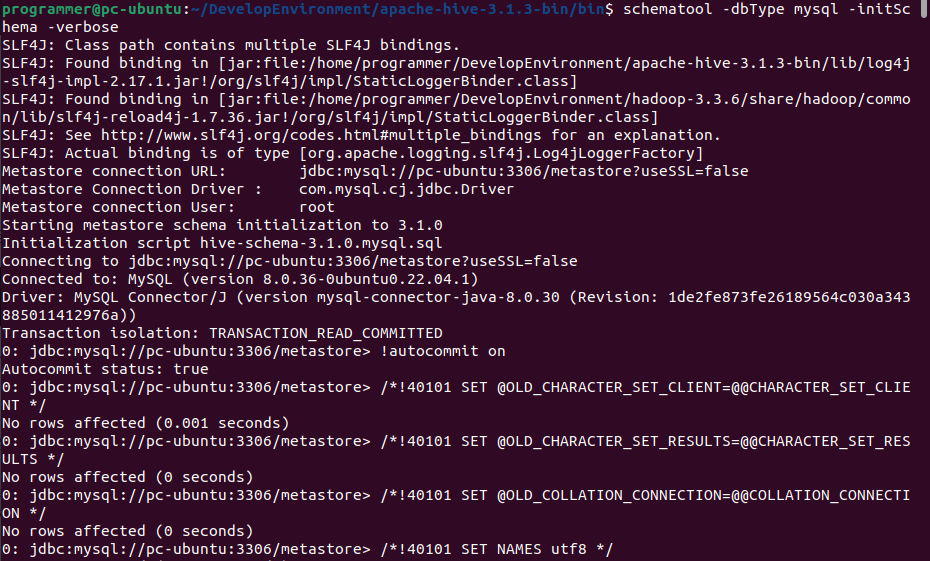

hive使用的是3.13版本,spark是3.3.3支持hadoop3.x

hive将engine从mr改成spark,通过beeline执行insert、delete时一直报错,sparkTask rpc关闭,

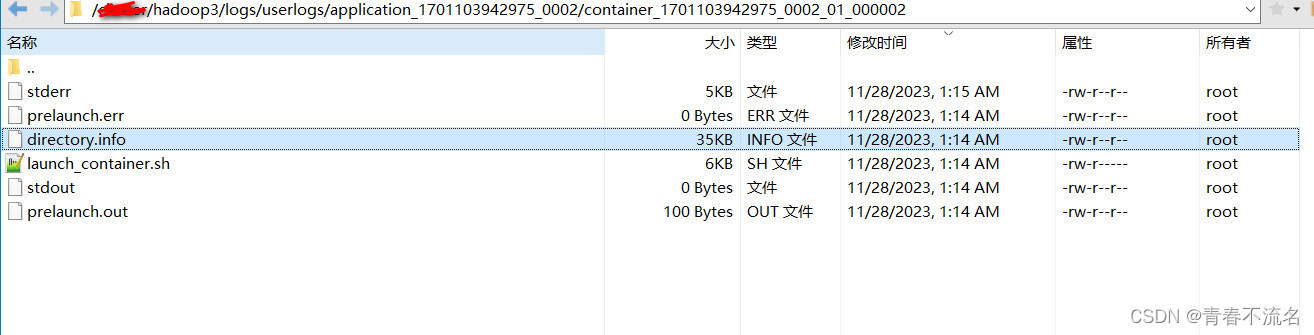

查看yarn是出现ClassNotFoundException: org.apache.hive.spark.client.Job。

开始以为是版本不兼容问题。spark3.3.3编译版本对应的hive是2.3.9

切换hive2.3.9依然是org.apache.hive.spark.client.Job找不到问题。

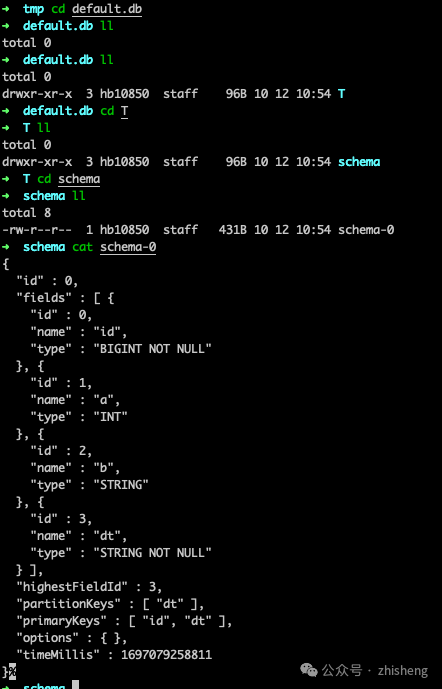

spark的jars目录存在hive–exec–core-2.3.9.jar,反复对比hive的lib目录,发现是hive-exec.jar没有core,将spark3.3.3下hive的hive-exec–core-2.3.9.jar删掉,替换成hive下的lib文件,重启spark和hive,这个错误消失了

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

![[Lucene]核心类和概念介绍](http://www.7code.cn/wp-content/uploads/2023/11/ee6748cbc735e6105405f8a984d954c804b93f34bc916-Z0IqTf_fw1200.png)