1. 背景

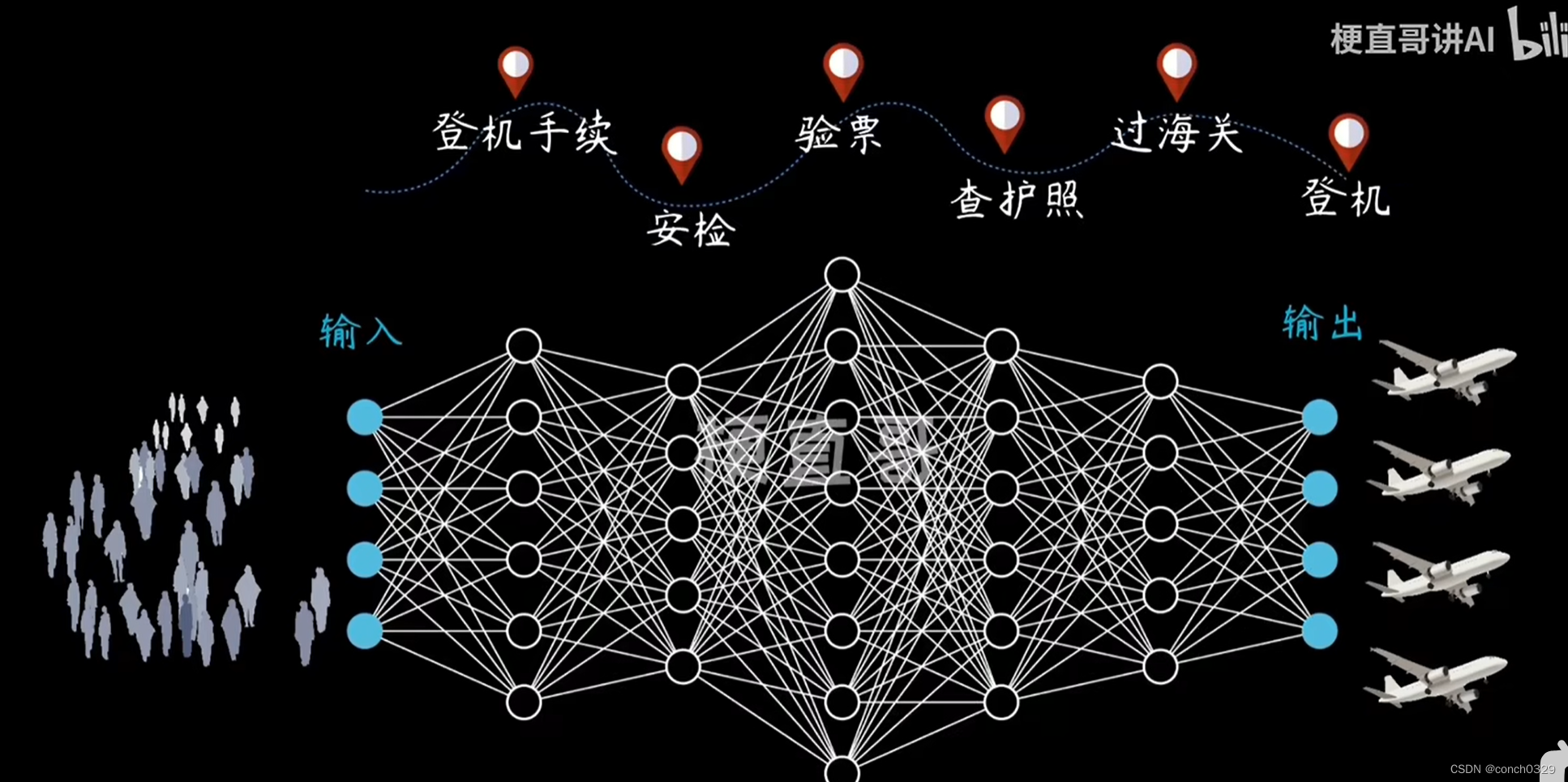

DT决策树是一种基本的分类与回归方法,其学习时,利用训练数据,根据损失函数最小化原则建立DT模型。

分类DT主要优点:模型具有可读性,分类速度快。

由DT树的根结点到叶结点的每一条路径构建一条规则,即组合特征,路径上内部结点

的特征对应着规则的条件,而叶结点的类对应着规则的结论。这些路径互斥且完备。

DT学习通常包括3个步骤:特征选择、DT的生成与DT的修剪。DT的生成只考虑局部最优,而DT的剪枝则考虑全局最优。

DT学习是由训练数据集估计条件概率模型,其损失函数通常是正则化的极大似然函数,其策略是损失函数为目标函数的最小化。

2. 特征选择

特征选择在于选取对训练数据具有分类能力的特征,这样可以提高DT学习的效率。通常特征选择的准则是信息增益或信息增益比。

2.1 熵

随机变量X的熵定义为 (对数以2为底时,熵的单位叫bit;以e为底时,熵的单位叫nat)。

其中 ,i=1,2,…,n

2.2 条件熵

2.3 信息增益及其计算

2.4 信息增益比

3. DT的生成

3.1 ID3算法

3.2 C4.5算法

4. DT的剪枝

5. CART算法

5.1 CART生成

5.1.1 回归树的生成

5.1.2 分类树的生成

5.2 CART剪枝

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。