机器学习在数据层、模型层以及应用层面临的安全和隐私威胁,呈现出多样性、隐蔽性和动态演化的特点。

应用领域:计算机视觉、自然语言处理、语音识别等

应用场景:自动驾驶、人脸识别、智慧医疗等

Key words: machine learning; poisoning attack; adversarial example; model privacy; artificial intelligence security

引言

机器学习模型在生命周期的各个阶段都可能面临着不同程度的安全风险,导致模型无法提供正常的服务或者是泄露模型的隐私信息。例如,攻击者可能对模型的训练数据和输入样本进行恶意篡改或是窃取模型参数,从而破坏模型的机密性、可用性和完整性,这就是机器学习模型面临的安全与隐私问题。

机器学习的CIA模型

机器学习模型安全需求总结为三个特性:机密性(Confidentiality)、完整性(Integrity)和可用性

(Availability),即机器学习中的 CIA 模型。

机器学习的 CIA 三个特性都有可能被攻击破坏,所对应的攻击方法分别称为机密性攻击、完整性攻击和可用性攻击。

数据安全风险与保护

攻击者通过将精心制作的样本插入训练集中来操纵训练数据分布,以达到改变模型行为和降低模型性能的目的,这种类型的攻击被称为“数据投毒”(Data Poisoning)攻击。

投毒攻击

后门攻击(Backdoor Attack)

木马攻击(Trojan Attack)

防御方法

大多数针对投毒攻击的防御机制依赖于一个事实(前提),即投毒样本通常在预期输入分布之外。因此可以将投毒样本视为异常值,可以使用数据清理(即攻击检测和删除)和鲁棒学习(即基于对边远训练样本本质上不太敏感的鲁棒统计的学习算法)来净化训练样本。

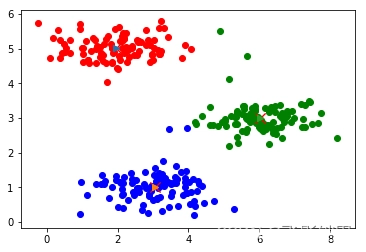

鲁棒学习:基于主成分分析(Principal Component Analysis,PCA)的投毒攻击检测模型

数据清理:掩蔽特征(Masked Features)、DUTI

后门攻击检测:激活聚类(Activation Clustering,AC)