本文介绍: 在本文中,深入研究了 Apache Kafka 的起源、设计原则和关键概念,以及其在大数据领域的重要应用。从分布式架构、持久性、高性能等设计原则出发,探讨了 Kafka 在实时数据处理、流式数据处理、实时日志处理等应用场景中的广泛应用,并提供了相应的示例代码。了解 Kafka 的核心概念,如 Topic、Partition、生产者和消费者,以及 Offset 的作用,有助于更好地理解其工作原理。在高级特性方面,介绍了 Kafka 的事务支持和消息传递保证,为实现原子操作和消息可靠性提供了强大的工具。

Apache Kafka 是一个分布式流处理平台,被广泛用于构建实时数据流应用程序和大数据处理系统。本文将深入探讨 Kafka 的起源、设计原则以及它在大数据领域中的重要作用。

大数据和实时数据处理背景

在大数据时代,处理海量数据和实时数据成为了一项关键挑战。传统的消息传递系统往往难以满足实时性和可伸缩性的需求。这正是 Kafka 出现的背景。Kafka 最初由 LinkedIn 公司开发,用于满足其实时数据处理和日志收集的需求。

Kafka 的设计原则

Kafka 的设计基于一些关键原则,使其成为一个高性能、可伸缩、持久化的分布式消息系统。

1 分布式架构

Kafka 采用分布式架构,可以轻松地扩展到多个节点,以处理高吞吐量和大规模数据。

2 持久性

Kafka 的消息被持久化存储在磁盘上,保证消息不会丢失,即使消费者未及时处理。

3 高性能

Kafka 的应用场景

1 实时日志处理

2 流式数据处理

Kafka 的核心概念

1 Topic 和 Partition

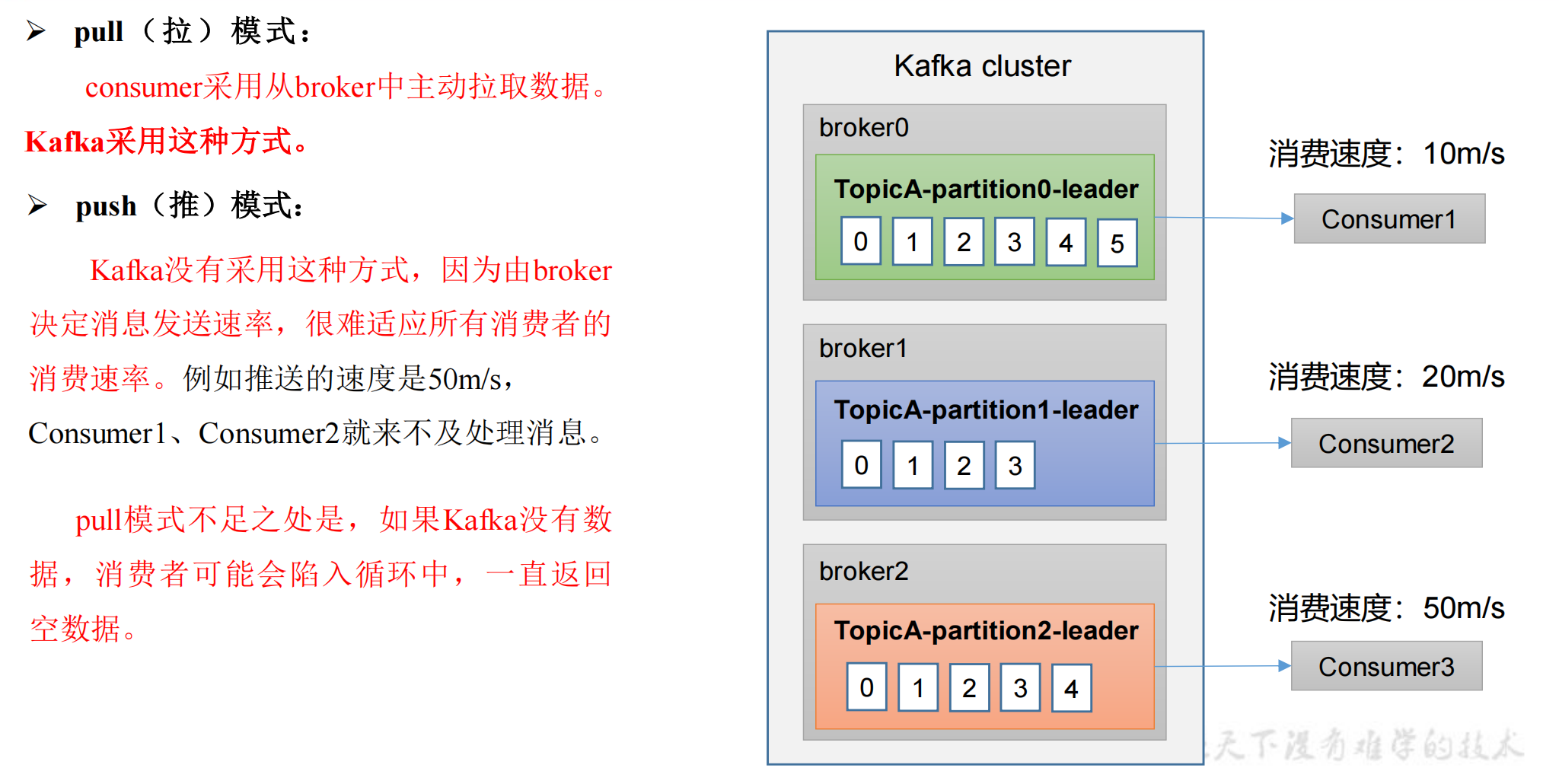

2 生产者和消费者

3 Offset

Kafka 的高级特性

1 事务支持

2 消息保证

Kafka 生态系统的其他组件

1 Kafka Connect

2 Kafka Streams

总结

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。