本文介绍: 通过集成Spark与HBase,可以充分利用这两个强大的工具来处理和分析大规模数据。本文深入介绍了如何集成Spark与HBase,并提供了示例代码,以帮助大家更好地理解这一过程。同时,也提供了性能优化的建议,以确保在集成过程中获得良好的性能表现。

Apache Spark和Apache HBase分别是大数据处理和分布式NoSQL数据库领域的两个重要工具。在本文中,将深入探讨如何在Spark中集成HBase,并演示如何通过Spark访问和操作HBase中的数据。将提供丰富的示例代码,以便更好地理解这一集成过程。

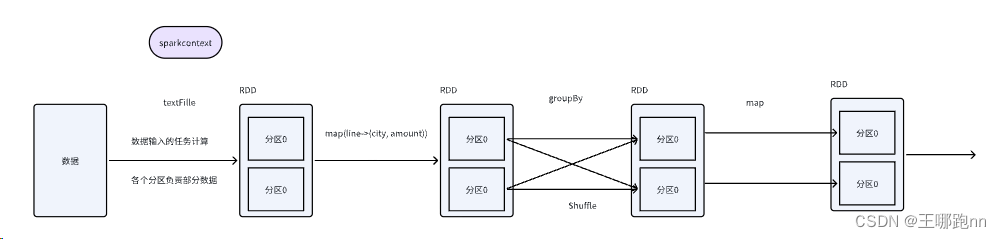

Spark与HBase的基本概念

在开始集成之前,首先了解一下Spark和HBase的基本概念。

集成Spark与HBase

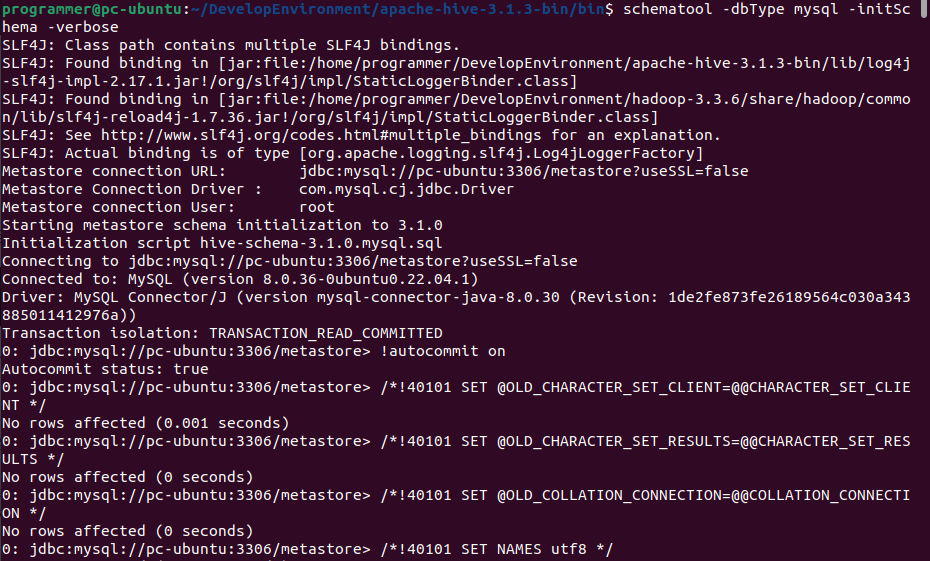

要在Spark中集成HBase,首先需要添加HBase的依赖库,以便在Spark应用程序中使用HBase的API。

以下是一个示例代码片段,演示了如何在Spark中进行集成:

在上述示例中,首先创建了一个Spark会话,然后通过addPyFile方法添加了HBase的配置文件hbase-site.xml。这个配置文件包含了与HBase集群的连接信息。

使用HBase的API

1. 读取数据

2. 写入数据

3. 扫描数据

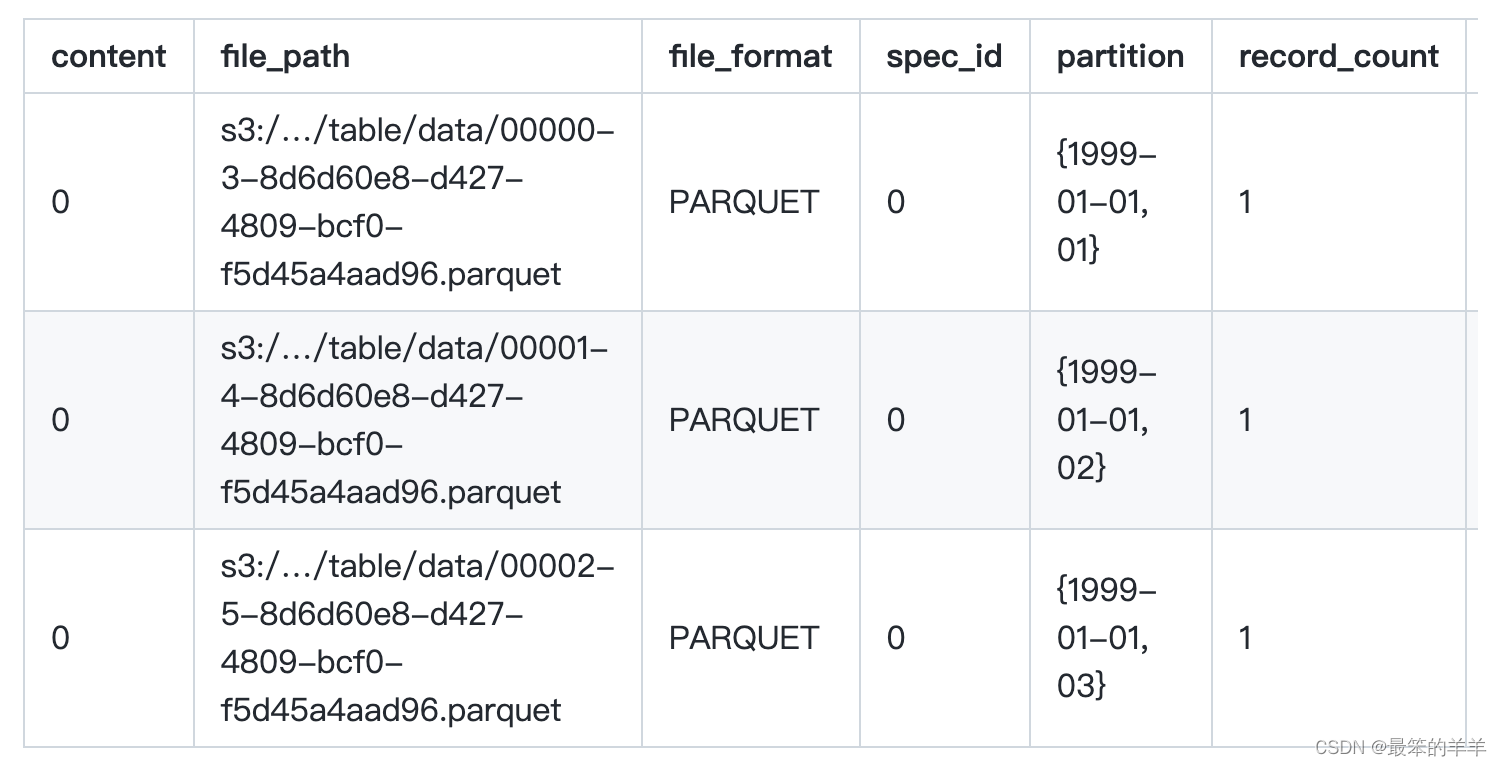

将HBase数据转换为Spark DataFrame

性能优化

示例代码:将HBase数据加载到Spark DataFrame

总结

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。