本文介绍: pytorch中loss function损失函数的使用举例,以及损失函数中backward()的使用

损失函数

torch提供了很多损失函数,可查看官方文档Loss Functions部分

损失函数用法差不多,这里以L1Loss和MSEloss为例

反向传播

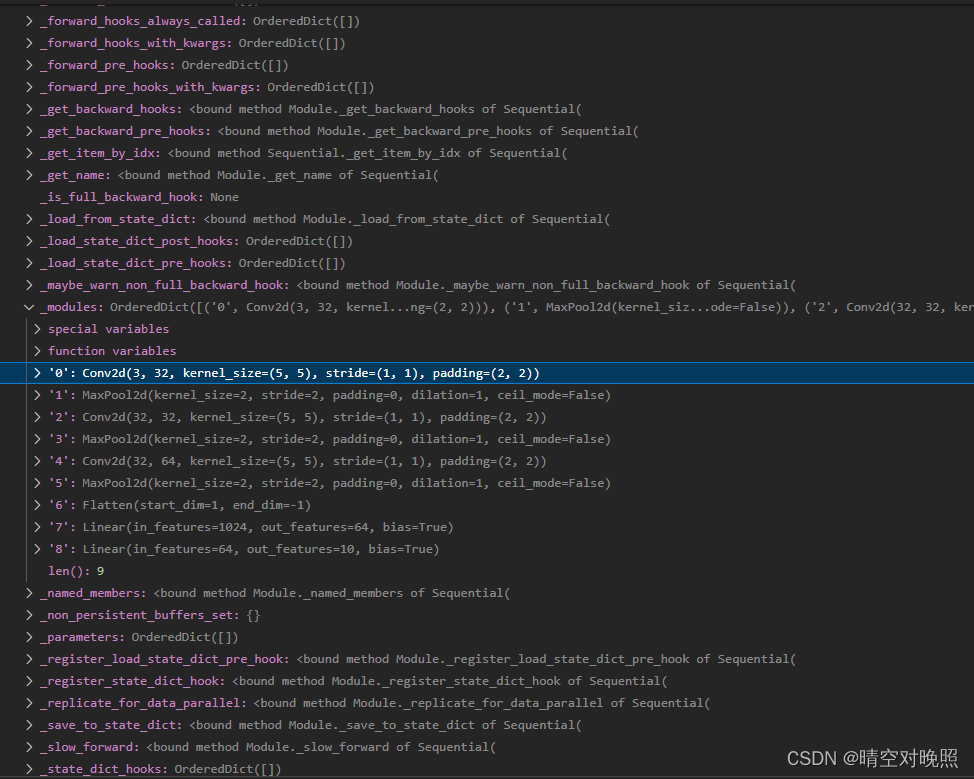

加上反向传播后:

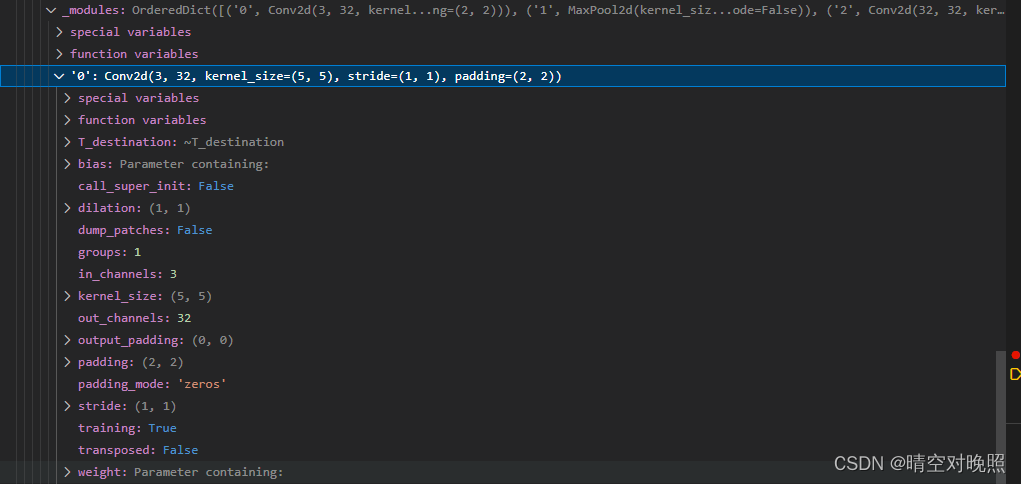

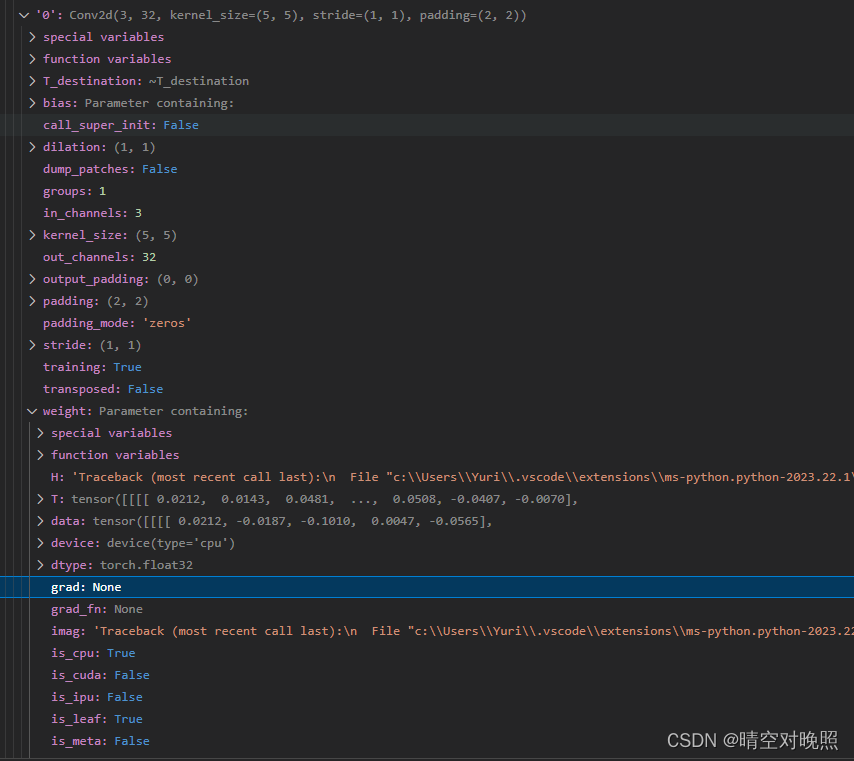

backward行打断点,进入调试界面可以查看网络内部的参数

weighr里面有grad

运行到backward之前,grad里是none

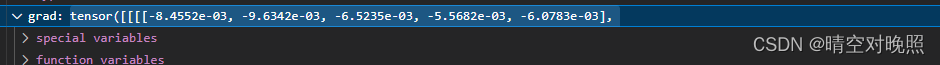

运行完之后,计算出梯度

后面可以使用优化器,利用计算出来的梯度,对神经网络进行更新

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。