本文介绍: ElasticSearch-IK分词器(elasticsearch插件)安装配置和ElasticSearch的Rest命令测试

四、IK分词器(elasticsearch插件)

分词:即把一段中文或者别的划分成一个个的关键字,我们在搜索时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一一个匹配操作,默认的中文分词是将每个字看成一个词(不使用用IK分词器的情况下),比如“我爱狂神”会被分为”我”,”爱”,”狂”,”神” ,这显然是不符合要求的,所以我们需要安装中文分词器ik来解决这个问题。

IK提供了两个分词算法: ik_smart和ik_max_word ,其中ik_smart为最少切分, ik_max_word为最细粒度划分!

1、下载

下载地址:https://github.com/medcl/elasticsearch-analysis-ik/releases

2、安装

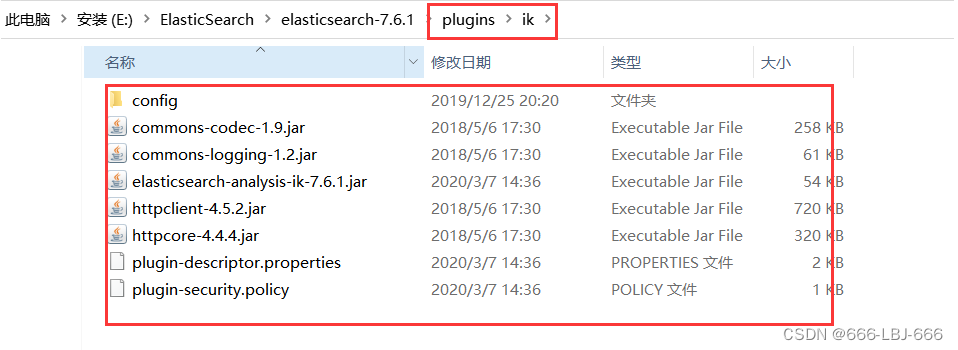

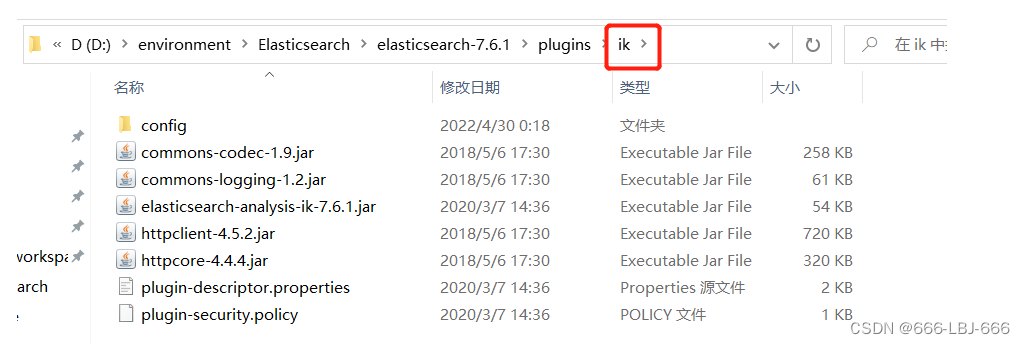

加压即可(但是我们需要解压到ElasticSearch的plugins目录ik文件夹下)

3、重启ElasticSearch

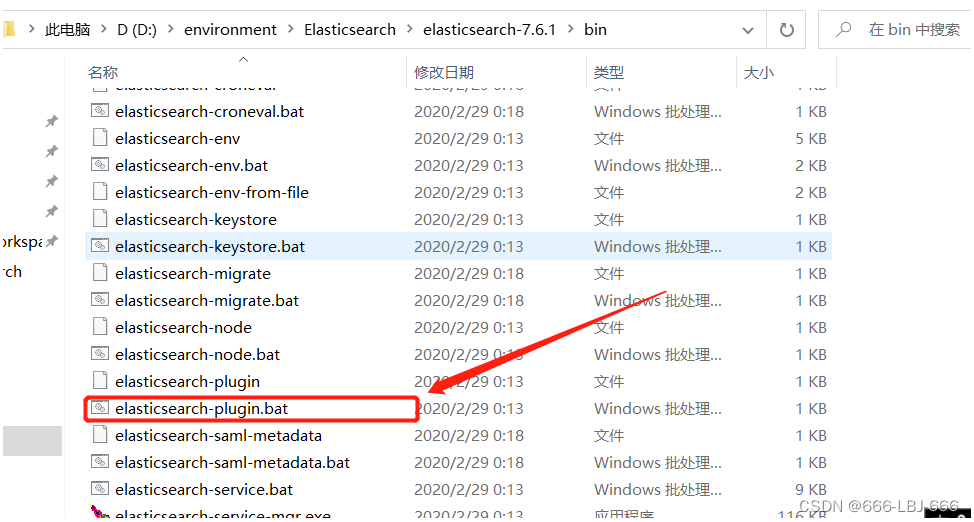

4、使用 ElasticSearch安装补录/bin/elasticsearch-plugin 可以查看插件

5、使用kibana测试

6、添加自定义的词添加到扩展字典中

五、Rest风格说明

1、基本Rest命令说明:

2、测试

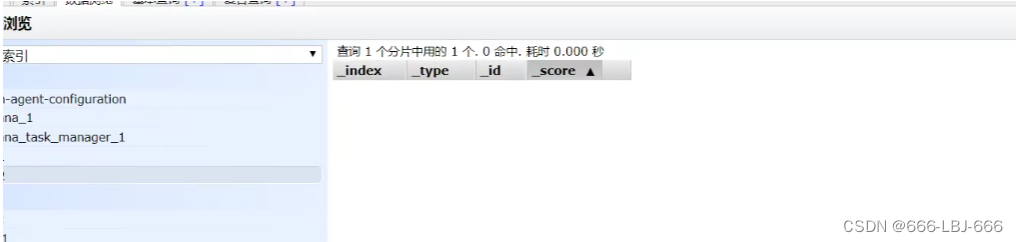

1)创建一个索引,添加

2)字段数据类型

3)指定字段的类型(使用PUT)

4)获取3建立的规则

5)获取默认信息

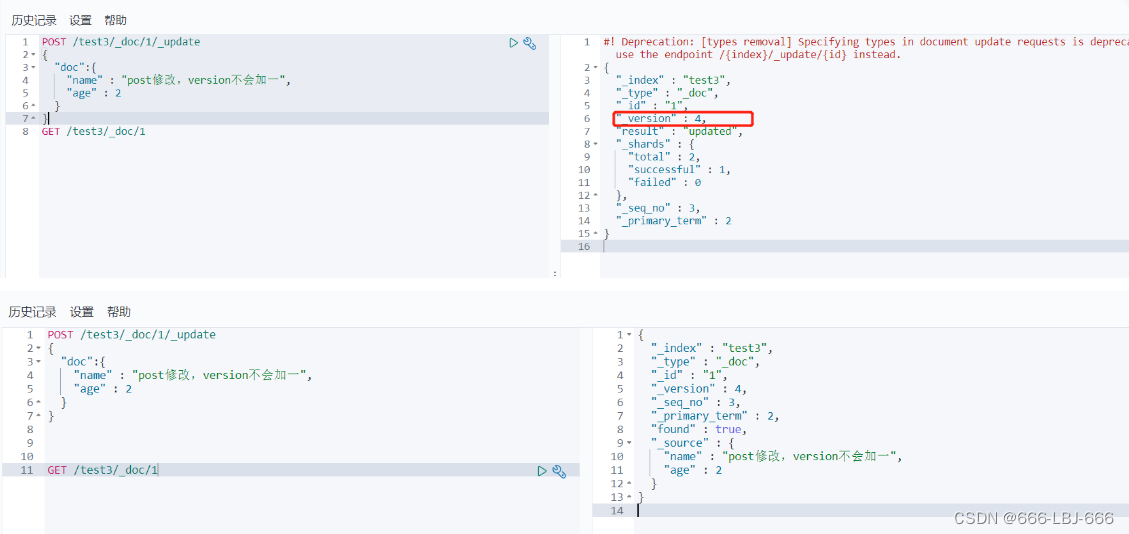

6)修改

7)删除

8)查询(简单条件)

9)复杂查询

①查询匹配

②多条件查询(bool)

③匹配数组

④精确查询

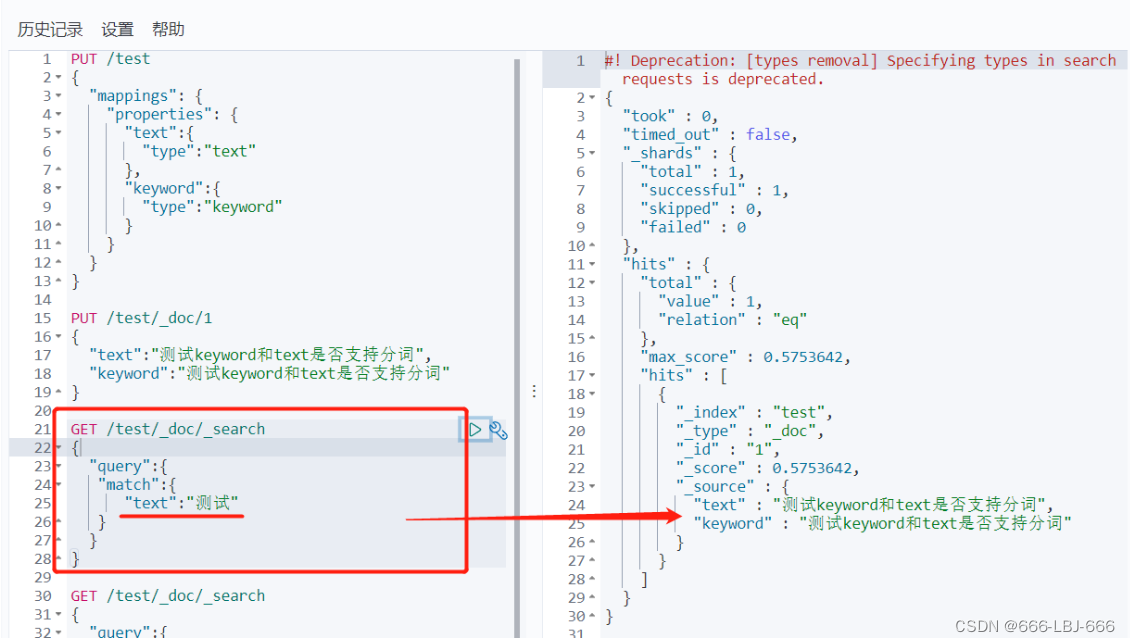

⑤text和keyword

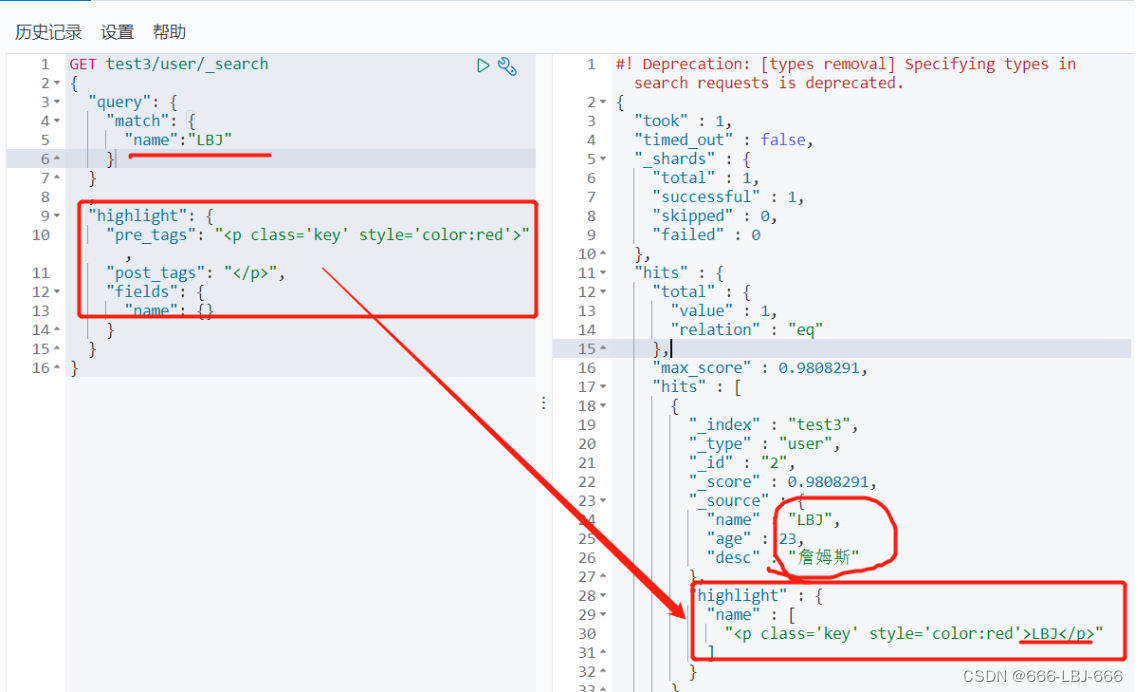

⑥高亮查询

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。