本文介绍: Python实现从句子分词的基本操作,两个库:spaCy 与 NLTK,以及进行词形还原和词干提取

在自然语言处理(NLP)中,文本分词是将文本拆分为单词或词组的过程,这是理解文本含义和结构的基础。Python中两个流行库——spaCy和NLTK(Natural Language Toolkit),都提供了分词功能。下面将详细介绍如何使用这两个库进行文本分词等操作。

准备工作

spaCy

如果没有安装 spaCy 库,请安装:

安装好 spaCy 库后,下载语言模型:

常用的语言模型还包含:中文模型(zh_core_web_sm)

更多语言模型请见:https://spacy.io/models

完成库的安装以及英文包的下载。

NLTK

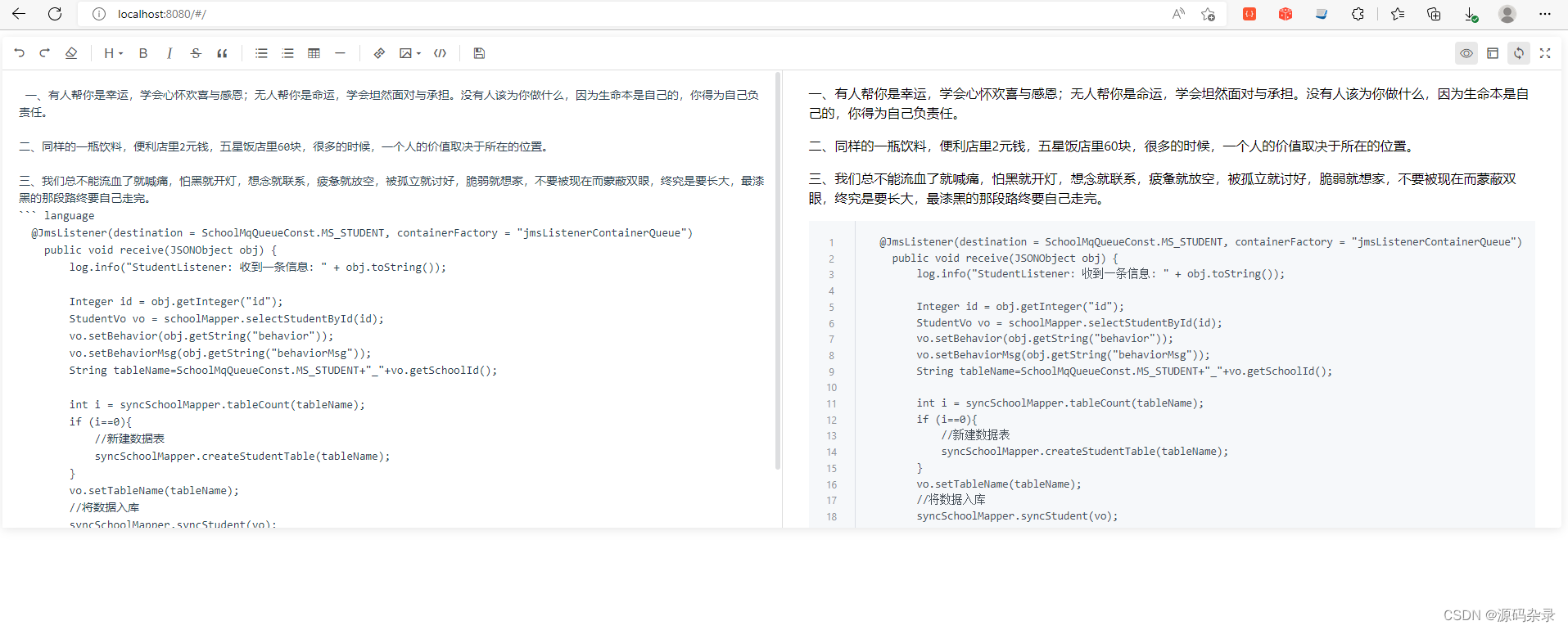

文本分词

spaCy

NLTK

词形还原

spaCy

NLTK

词干提取

Porter

Snowball stemmers

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。