本文介绍: 回顾一下,你使用 Azure NetApp 文件作为后端存储解决方案,以便在 Azure 上运行 HPC 和 EDA 应用程序。你需要了解性能技巧和最佳做法,以提高这些应用程序的 Azure NetApp 文件性能。本模块介绍了关于参考体系结构、客户端 VM 和网络的性能建议。然后,我们讨论了几个性能技巧,包括装载选项和客户端 VM 配置。最后,我们检查了 SPEC EDA 和 FIO 基准检验结果,以验证所讨论的性能技巧。

介绍

Azure NetApp 文件是一项托管存储解决方案,适用于各种方案,包括高性能计算 (HPC) 基础结构。 低延迟和每秒高 I/O 操作数 (IOPS) 对于大规模企业而言是一种很好的组合。

假设你就职于一家半导体公司。 你的任务是设计公司的集成电路芯片,其需要很多电子设计自动化 (EDA) 模拟。 你在本地没有足够的容量用于此项目,因此你决定使用 Azure 来满足那些 HPC 模拟需求。

管理层希望你能够及时且经济高效地完成此项目。 你选择 Azure NetApp 文件作为后端存储解决方案,因为它提供了与本地类似的体验和性能。 你需要了解性能技巧和最佳做法,以提高 EDA 应用程序的 Azure NetApp 文件性能。

本模块介绍关于参考体系结构、客户端虚拟机 (VM) 和网络的性能建议。 接下来,我们讨论性能技巧,包括装载选项和客户端 VM 配置。 最后,我们检查基准检验结果,以验证所讨论的性能技巧。

学习目标

学习完本模块以后,您将能够:

先决条件

总体性能建议

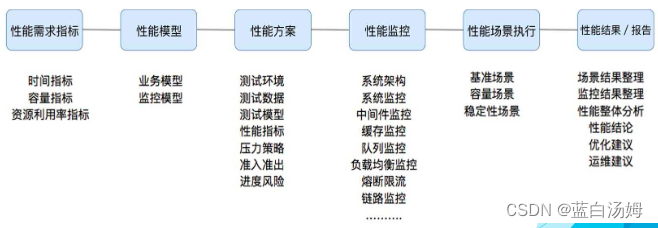

在此模块中,我们介绍在 Azure NetApp 文件上运行 EDA 应用程序时关于参考体系结构、客户端 VM 和网络的性能建议。

通过审阅参考体系结构来了解 EDA 工作负载

关于虚拟网络、加速网络和客户端更新的建议

装载选项和客户端 VM 配置

使用 actimeo 和 nocto 装载选项来提高性能

调整系统参数以获得最佳性能

适当时,使用装载选项 nconnect 扩展网络连接

当只考虑性能时,使用 NFSv3,而不是 NFSv4.1

为 rsize 和 wsize 装载选项选择适当大小

为 hard、soft 和 intr 装载选项选择适当的设置

考虑不更改 MTU

装载示例

基准结果

这两个基准工具的概览

SPEC EDA 工具的基准检验结果

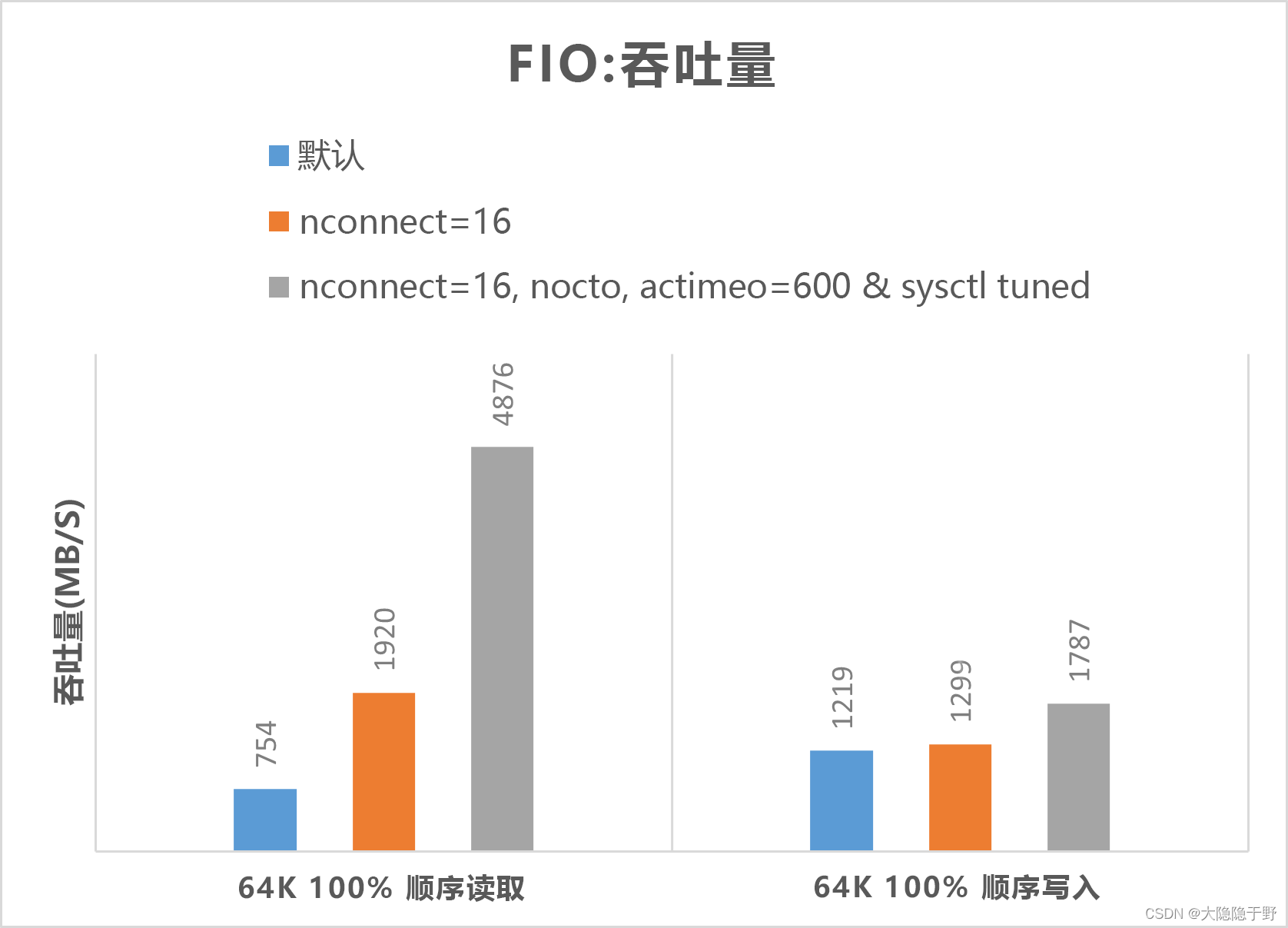

FIO 工具的基准结果

摘要

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

下图表明,NFSv3 的性能优于 NFSv4.1。

下图表明,NFSv3 的性能优于 NFSv4.1。 下图表明,

下图表明,