本文介绍: 预训练提高了模型在分类和生成任务的精度,但缺点是成本较高,性能慢;剪枝是一种减少模型大小的有效方法;论文引入了块剪枝方法,为了得到小且快的模型。通过将任意大小的块剪枝集成到运动剪枝微调范式中;实验在分类和生成任务,得到剪枝后的模型2.4x更快,74%更小的BERT在SQuAD v1,F1仅下降1%,与其他蒸馏模型相比速度更快,与其他剪枝模型相比模型更小。

NN Pruning

《Block Pruning For Faster Transformers》

《为更快的transformer进行块修剪》

摘要

预训练提高了模型在分类和生成任务的精度,但缺点是成本较高,性能慢;

剪枝是一种减少模型大小的有效方法;

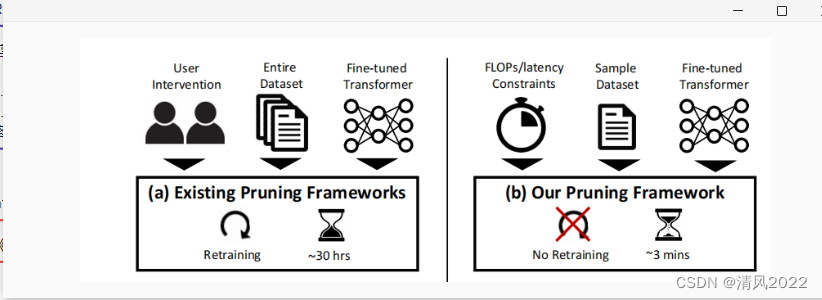

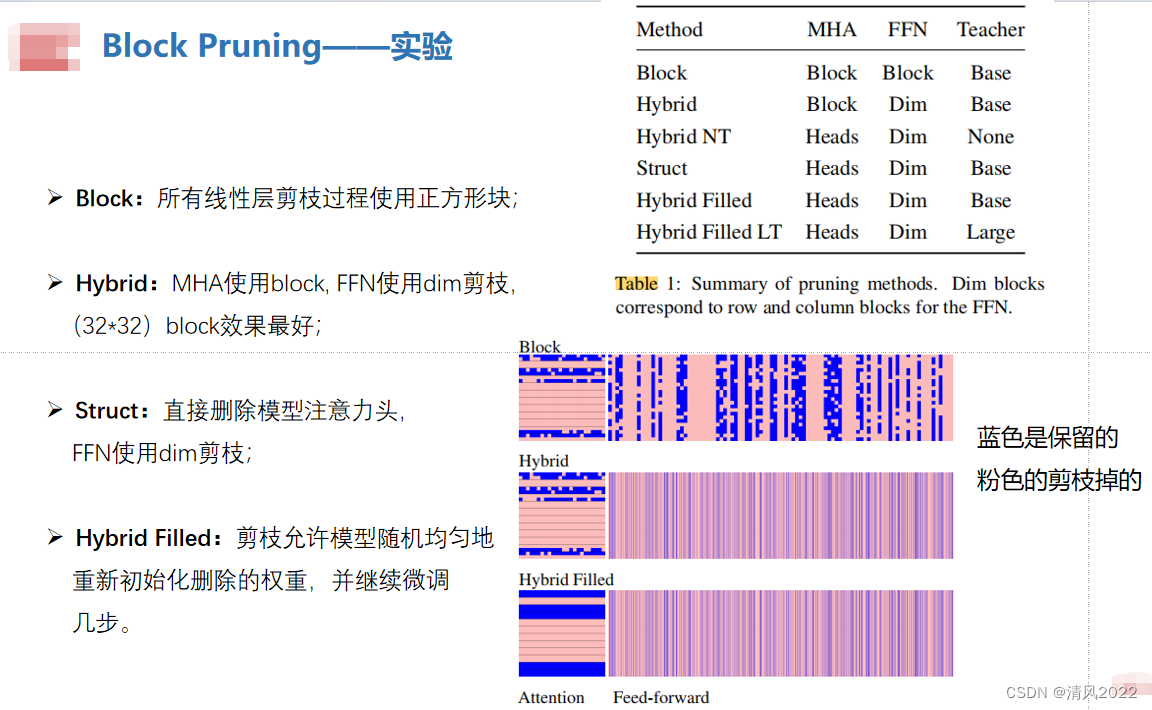

论文引入了块剪枝方法,为了得到小且快的模型。通过将任意大小的块剪枝集成到运动剪枝微调范式中;

实验在分类和生成任务,得到剪枝后的模型2.4x更快,74%更小的BERT在SQuAD v1,F1仅下降1%,与其他蒸馏模型相比速度更快,与其他剪枝模型相比模型更小。

实验

大模型剪枝

LLM-Pruner

SparseGPT

LTP

VTP

Width & Depth Pruning

Patch Slimming

DynamicViT

SPViT

DynamicBERT

ViT Slimming

FastFormers

NViT

UVC

Post-training pruning

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。