本文介绍: 我之前写过一篇文章:Python如何突破JA3,但方法非常复杂,很多初学者表示上手有难度。那么今天我来一个更简单的方法,只需要修改两行代码。并且不仅能过JA3,还能过Akamai。现在有很多网站,已经能够通过JA3或者其他指纹信息,来识别你的请求是不是Requests发起的。关于curl_cffi的更多用法,可以查看它的Github:Python binding for curl–impersonate via cffi[1]curl_cffi不仅完全兼容Requests的语法,而且还支持Asyncio。

概要

现在有很多网站,已经能够通过JA3或者其他指纹信息,来识别你的请求是不是Requests发起的。这种情况下,你无论怎么改Headers还是代理,都没有任何意义。

我之前写过一篇文章:Python如何突破JA3,但方法非常复杂,很多初学者表示上手有难度。那么今天我来一个更简单的方法,只需要修改两行代码。并且不仅能过JA3,还能过Akamai。

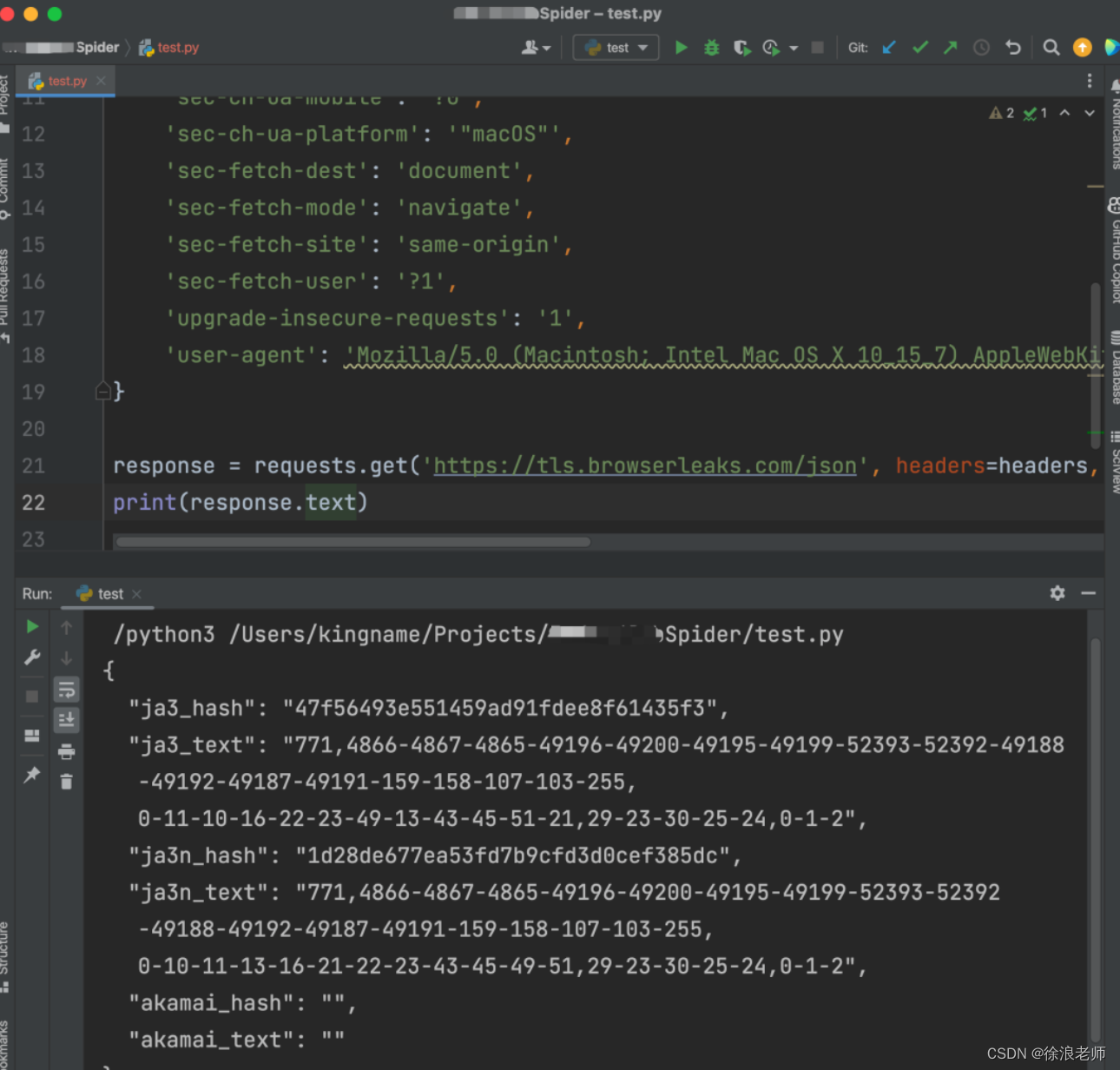

先来看一段代码:

```python

import requests

headers = {

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.7',

'accept-language': 'zh-CN,zh;q=0.9,en;q=0.8,en-GB;q=0.7,en-US;q=0.6',

'cache-control': 'no-cache',

'dnt': '1',

'pragma': 'no-cache',

'sec-ch-ua': '"Chromium";v="118", "Microsoft Edge";v="118", "Not=A?Brand";v="99"',

'sec-ch-ua-mobile': '?0',

'sec-ch-ua-platform': '"macOS"',

'sec-fetch-dest': 'document',

'sec-fetch-mode': 'navigate',

'sec-fetch-site': 'same-origin',

'sec-fetch-user': '?1',

'upgrade-insecure-requests': '1',

'user-agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/118.0.0.0 Safari/537.36 Edg/118.0.2088.46',

}

response = requests.get('https://tls.browserleaks.com/json', headers=headers)

print(response.json())

运行效果如下图所示:

## 整体架构流程

` 提示:这里可以添加技术整体架构`

这是直接使用Requests发起的请求。你可以试一试,加上代理以后,这里的ja3_hash并不会发生变化。并且akamai_hash和akamai_text都是空。这个特征是非常明显的,网站直接根据这些特征就可以屏蔽你的爬虫。

现在,我们使用两行代码解决这个问题。

首先,安装一个第三方库:curl_cffi:

python3 -m pip install curl_cffi

然后,修改我们这段代码的第一行,把import requests改成from curl_cffi import requests。最后,在requests.get中加一个参数:impersonate="chrome110"。完整效果如下图所示:

## 技术名词解释

```python

import asyncio

from curl_cffi.requests import AsyncSession

urls = [

"https://googel.com/",

"https://facebook.com/",

"https://twitter.com/",

]

async def main():

async with AsyncSession() as s:

tasks = []

for url in urls:

task = s.get("https://example.com")

tasks.append(task)

results = await asyncio.gather(*tasks)

asyncio.run(main())

技术细节

完成了。以上就是全部修改。网站已经无法识别你的爬虫了。在网站看来,这只是一个Chrome 110版本发起的请求。甚至Akamai需要的签名也都有了。

curl_cffi不仅完全兼容Requests的语法,而且还支持Asyncio。要使用异步写法时,代码如下:

小结

关于curl_cffi的更多用法,可以查看它的Github:Python binding for curl-impersonate via cffi[1]

原文地址:https://blog.csdn.net/liaozp88/article/details/134663388

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_28938.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。