一、目的

在实现Flume实时采集Linux中的Hive日志写入到HDFS后,再做一个测试,用Flume实时采集Linux中的目录文件,即使用 Flume 监听Linux整个目录的文件,并上传至 HDFS中

二、前期准备

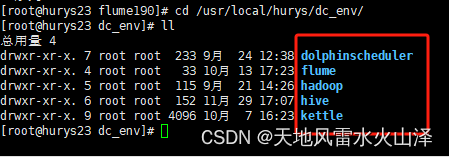

(一)安装好Hadoop、Hive、Flume等工具

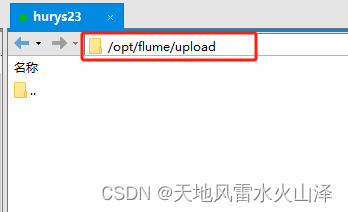

(二)Linux中被Flume监控的文件目录

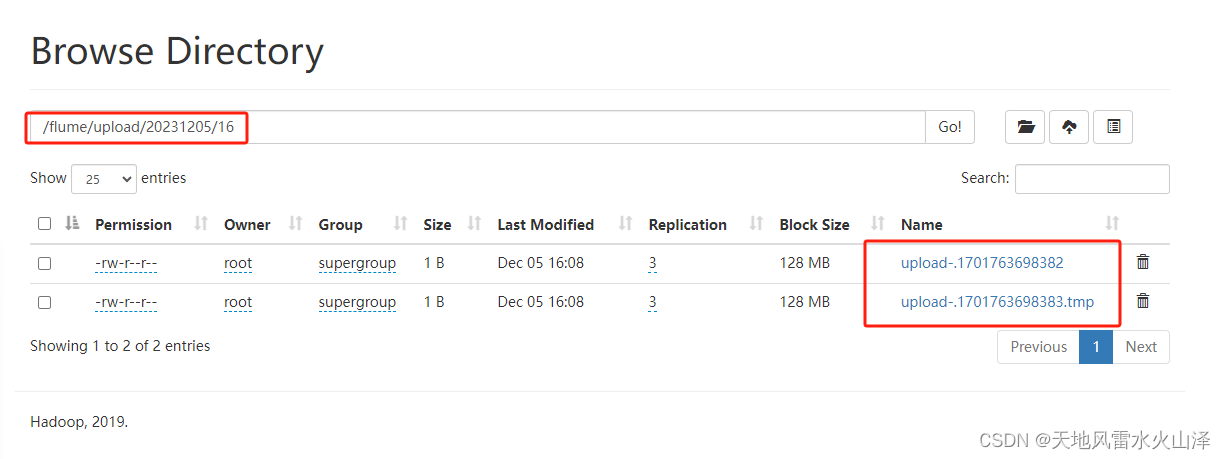

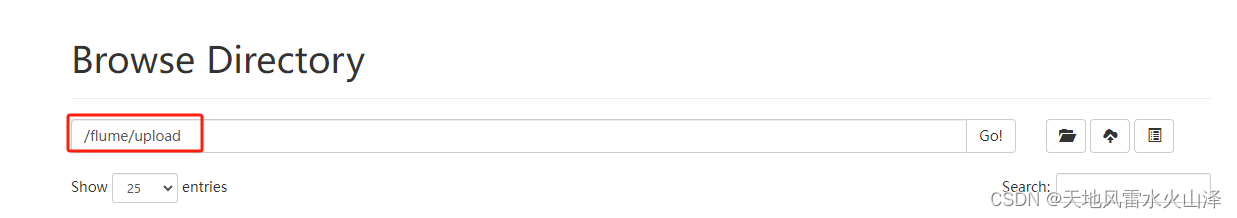

(三)在HDFS中创建文件夹/flume/upload,即写入的HDFS文件路径

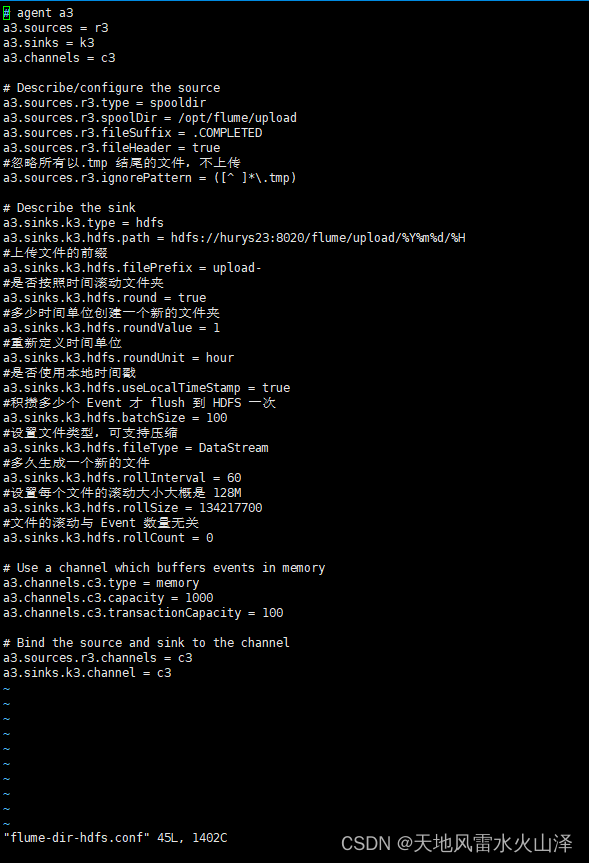

三、创建Flume的任务文件

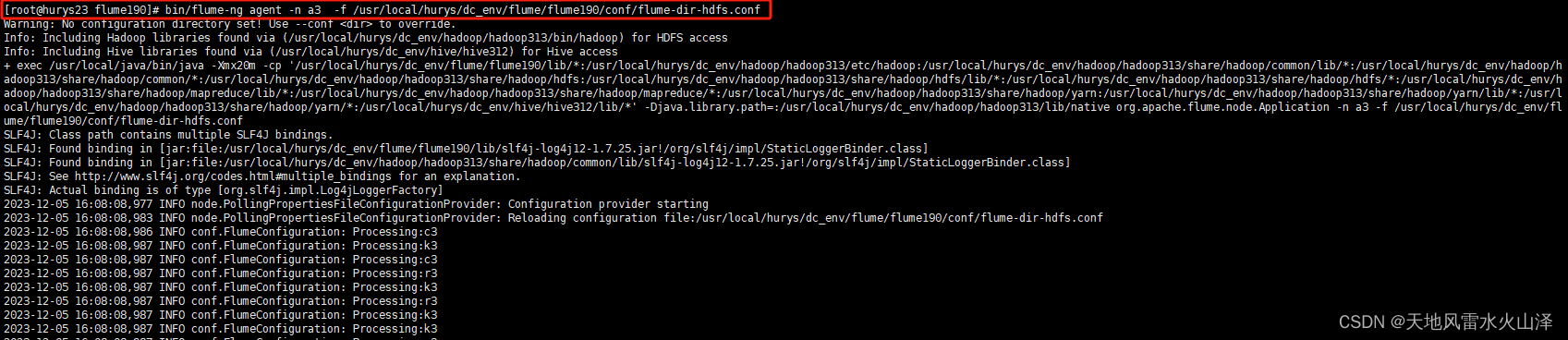

四、启动Flume任务文件

五、在Linux中被监控的目录文件夹创建新的文件

(一)到Linux目录文件下

(二)创建.txt文件 .log文件 .tmp文件

(三)创建文件后,ll查看文件状态

六、Flume任务运行时写入的HDFS文件状况

(一)目前时间戳

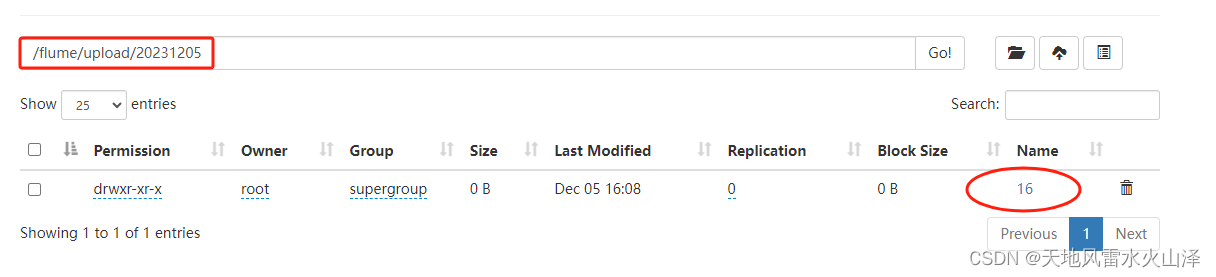

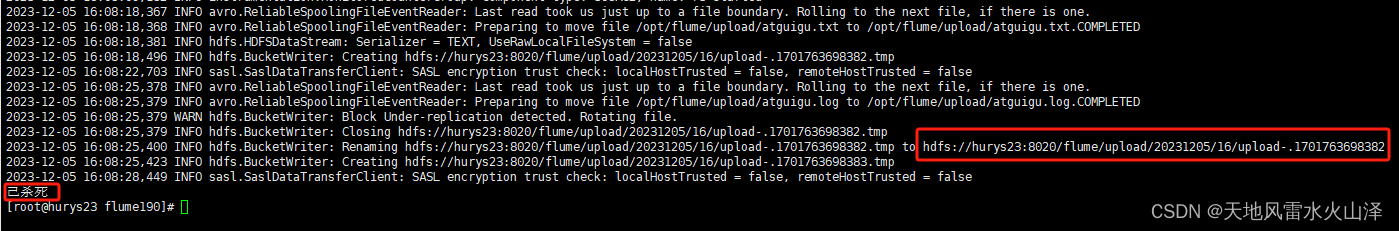

(二)HDFS生成了20231205文件夹、16文件夹及其upload文件

七、关闭Flume任务

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。