本文介绍: 目前,大语言模型的发展已经取得了显著的成果,如OpenAI的GPT系列模型、谷歌的BERT模型、百度的文心一言模型等。大语言模型的训练数据也可能存在偏见和歧视问题,这会影响模型的公正性和准确性。例如,如果训练数据中存在性别、种族、文化等方面的偏见,那么训练出的模型也会存在类似的问题。大语言模型的训练需要高质量的多模态数据,这些数据需要经过精确的标注和处理,以确保模型的训练效果。大语言模型的训练需要大量的数据,如何在保证数据隐私和安全的前提下,利用数据进行模型训练是一个重要的问题。

目前,大语言模型的发展已经取得了显著的成果,如OpenAI的GPT系列模型、谷歌的BERT模型、百度的文心一言模型等。这些模型在文本生成、问答系统、对话生成、情感分析、摘要生成等方面都表现出了强大的能力,为自然语言处理领域带来了新的突破。

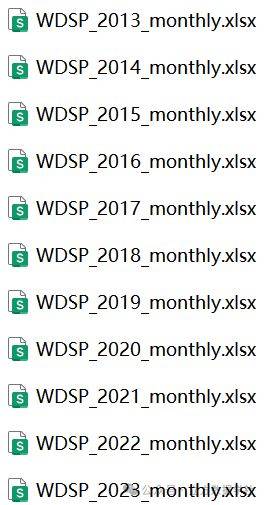

然而,这些大语言模型也存在一些有关数据方面的难题。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。