本文介绍: 运行上述命令后,会在当前目录新建workspace文件夹,里面存放着转化后的权重文件。以开始以为运行命令参数是 l。

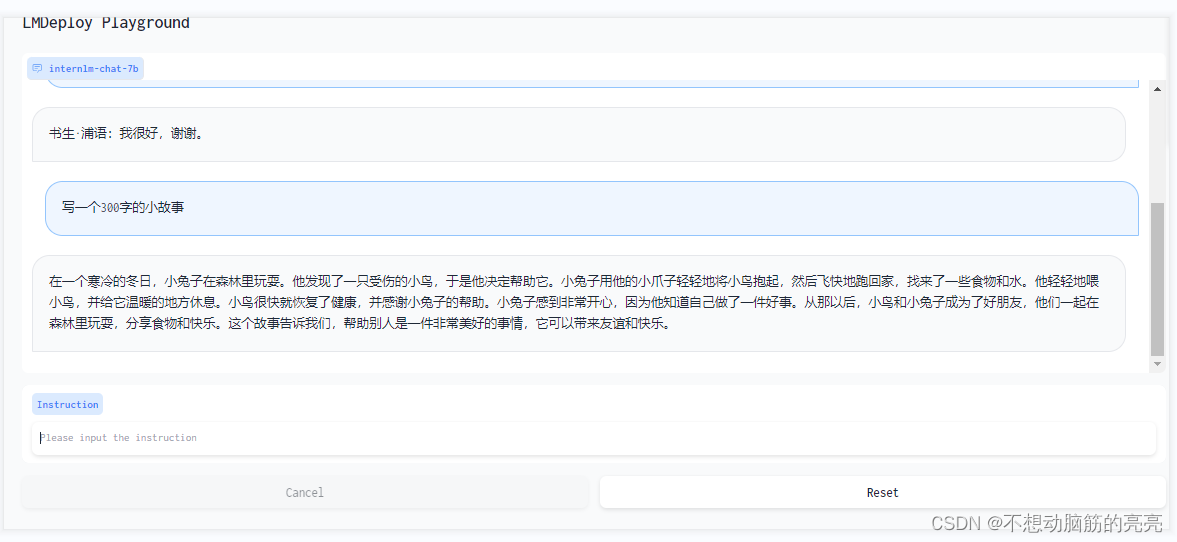

基础作业——使用LMDeploy 以本地对话、网页Gradio、API服务中的一种方式部署InternLM-Chat-7B模型,生成300字的小故事

环境准备

除了安装所需依赖之后,重要的是进行模型转化(转换成TurboMind格式),这里需要注意转化命令的具体用法:

运行上述命令后,会在当前目录新建workspace文件夹,里面存放着转化后的权重文件。以开始以为运行命令参数是 lmdelpoy convert 大模型原始路径 转化后的模型路径(实际不是)。

TurboMind推理 + 命令行本地对话

运行命令:

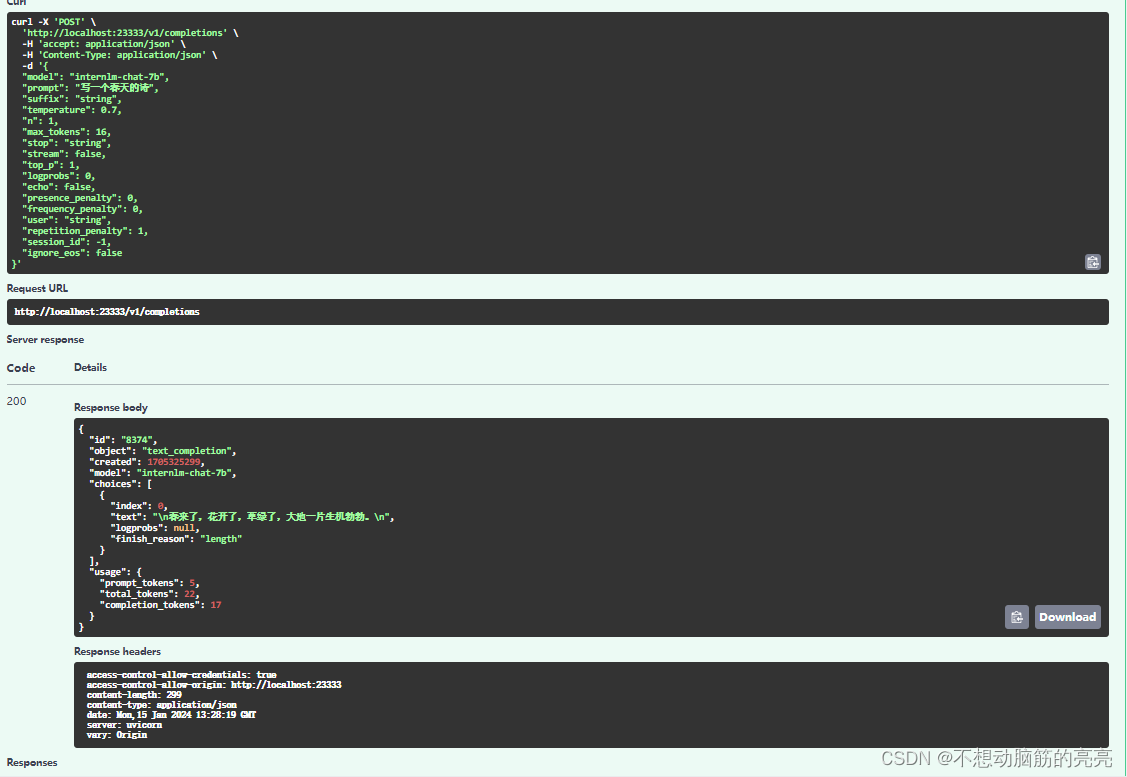

TurboMind推理 + API服务

TurboMind 推理 + 网页Demo演示

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。