摘要

本周学习了多视角自注意力网络,在统一的框架下联合学习输入句子的不同语言学方面。具体来说,提出并利用多种诱导性偏差来规则化常规的注意力分配。然后通过混合注意力机制聚合不同的视图,以方便地量化和利用特定的视图及其相关的表示。Self-attention是一种在自然语言处理(NLP)和深度学习领域中广泛应用的机制。它允许模型关注输入序列中的不同部分,并根据这些部分生成输出。通过学习输入序列中不同位置之间的关系,self-attention可以帮助模型更好地理解输入并产生更有意义的输出。在Transformer架构中,self-attention作为核心组件,提高了模型在各种NLP任务中的性能,包括机器翻译、文本分类和问答等。本文将介绍self-attention的基本原理、应用和未来的研究方向。

Abstract

This week, we learnt about multi-perspective self-attention networks that jointly learn different linguistic aspects of input sentences in a unified framework. Specifically, multiple induced biases are proposed and utilised to regularise regular attention allocation. The different views are then aggregated via a hybrid attention mechanism to facilitate the quantification and exploitation of specific views and their associated representations.Self-attention is a widely used mechanism in the fields of natural language processing (NLP) and deep learning. It allows a model to focus on different parts of an input sequence and generate output based on those parts. By learning the relationships between different locations in the input sequence, self-attention helps the model to better understand the input and produce more meaningful output. In the Transformer architecture, self-attention serves as a core component that improves the model’s performance in a variety of NLP tasks, including machine translation, text categorisation, and Q&A. In this paper, we present the fundamentals, applications, and future research directions of self-attention.

一、文献阅读

1.论文标题

Multi-view self-attention networks

2.论文摘要

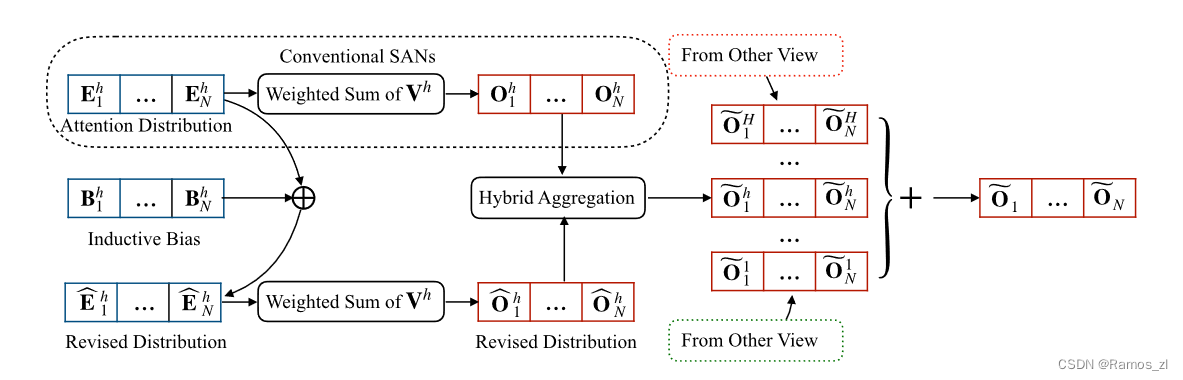

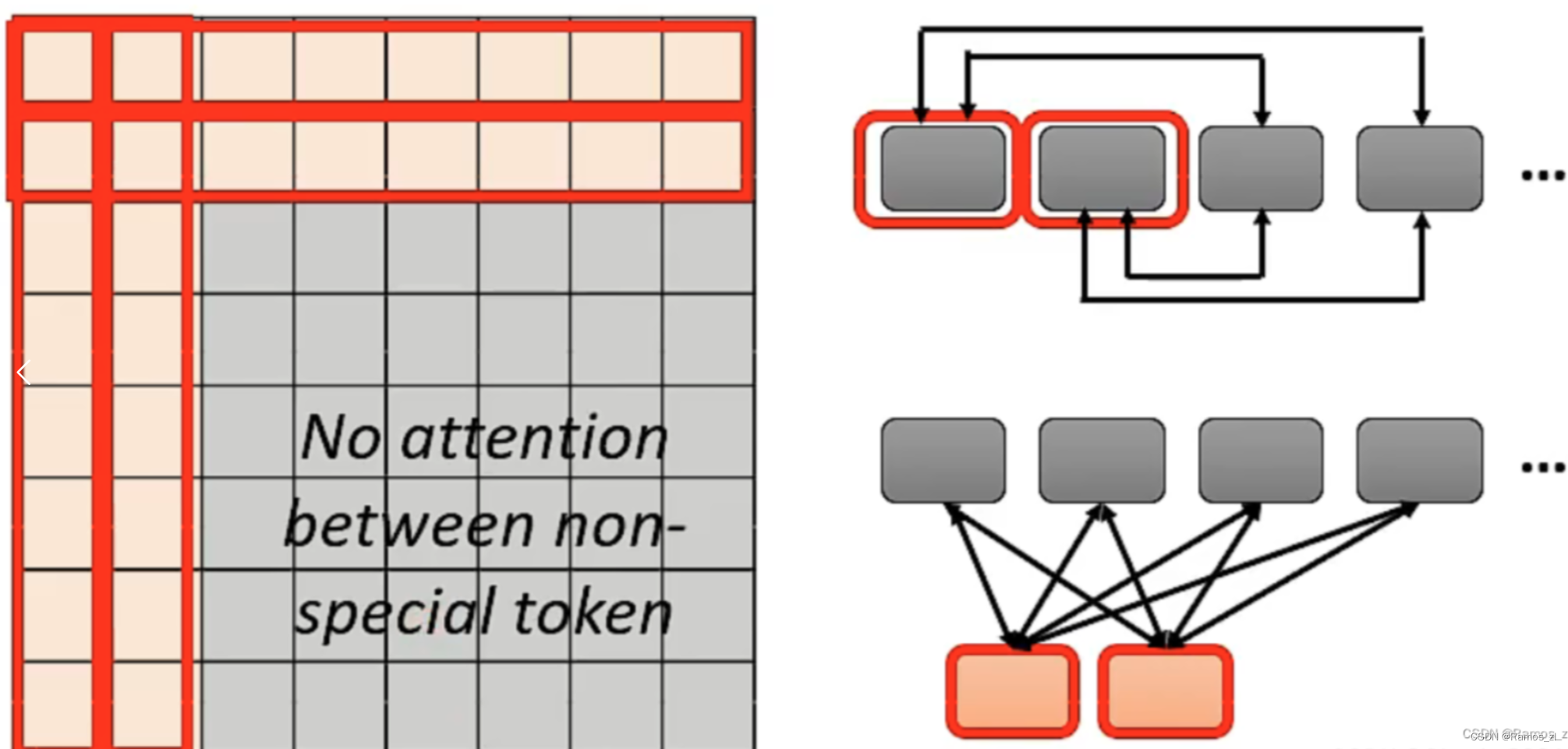

最近的研究证明,通过利用不同的归纳偏见,SAN可以得到进一步的改进,这些偏见指导SAN学习输入句子的特定视图,如短期依赖关系、前后视图和短语模式。然而,较少有研究探讨这些归纳技术如何互补地提高SAN的能力,这将是一个有趣的问题。在本文中,我们选取了五个简单且不过度参数化的归纳偏误来考察它们的互补性。本文提出了多视角自注意力网络,在统一的框架下联合学习输入句子的不同语言学方面。具体来说,提出并利用多种诱导性偏差来规则化常规的注意力分配。然后通过混合注意力机制聚合不同的视图,以方便地量化和利用特定的视图及其相关的表示。在各种翻译任务上的实验表明,不同的视图能够逐步改善SAN的性能,并且所提出的方法在Transformer – base和Transformer – big设置上优于强Transformer基线和相关模型。

3.论文背景

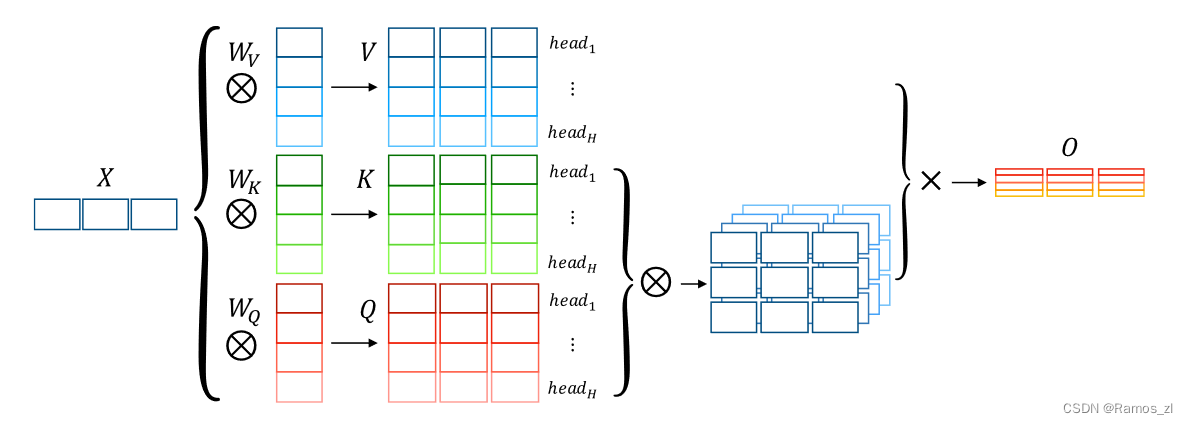

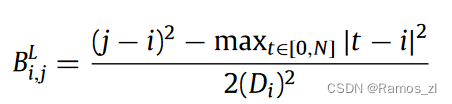

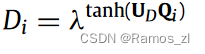

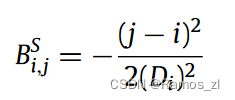

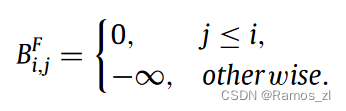

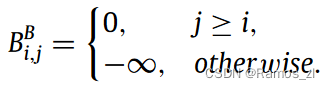

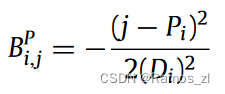

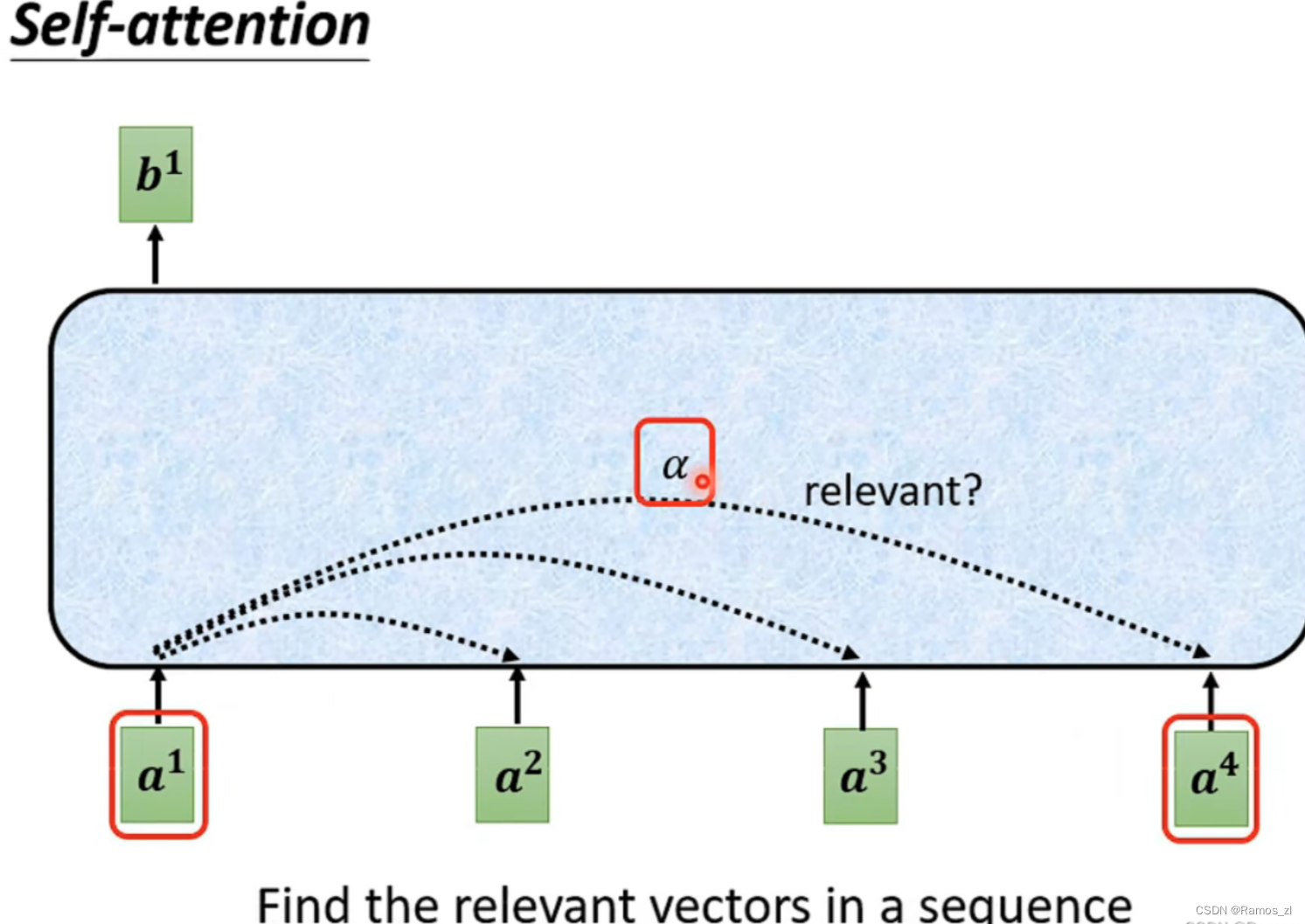

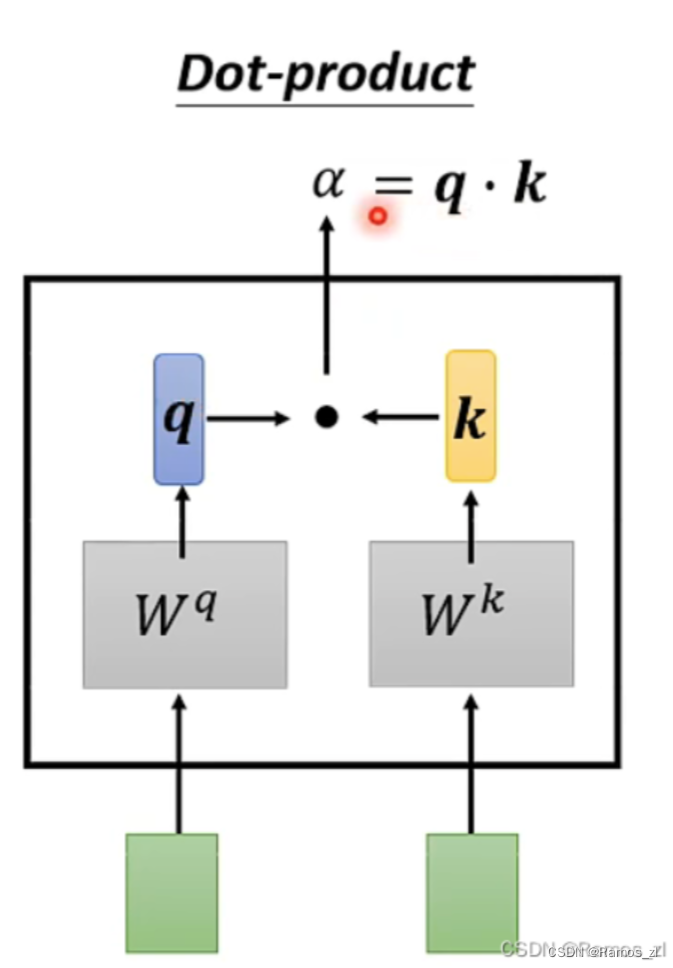

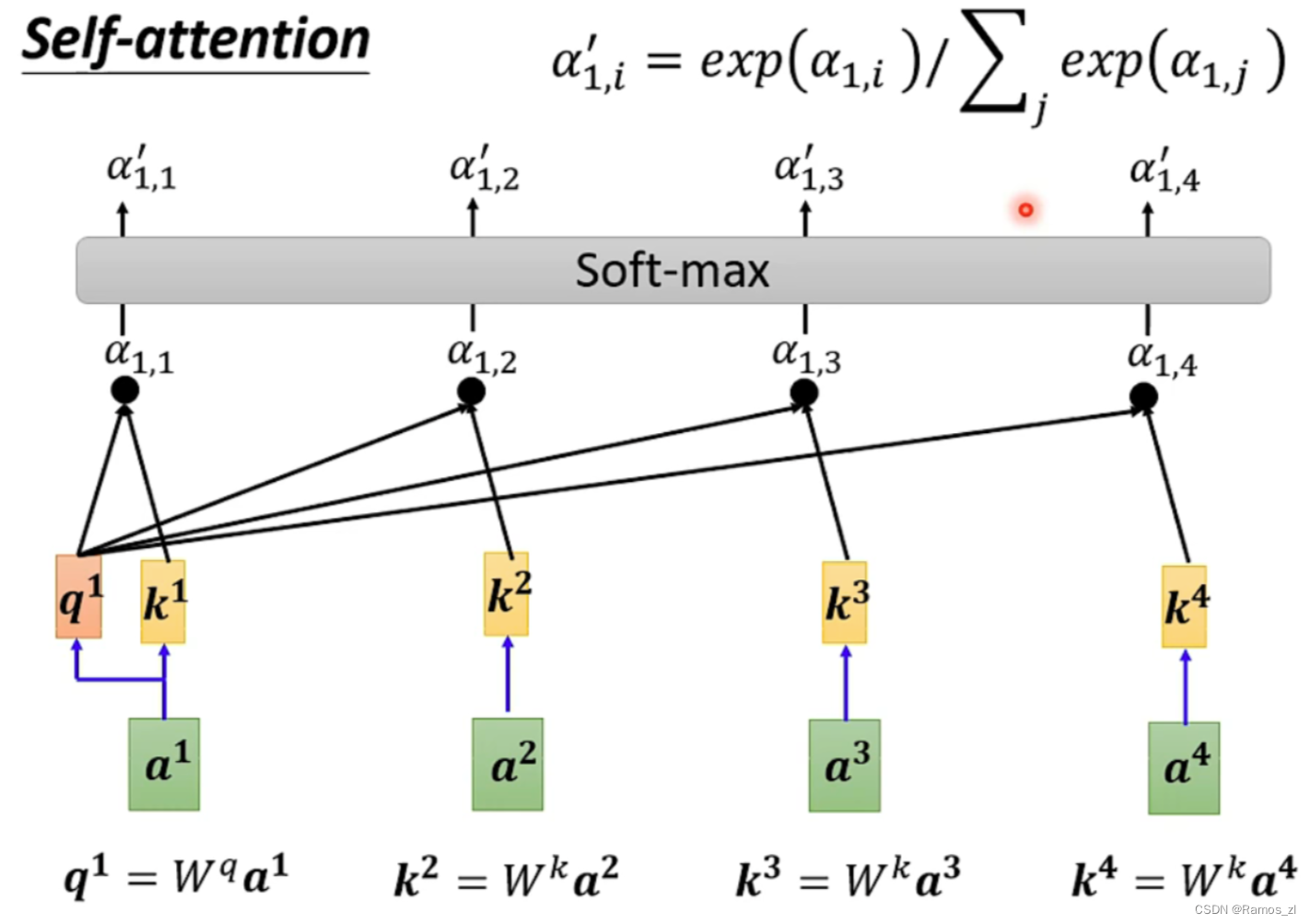

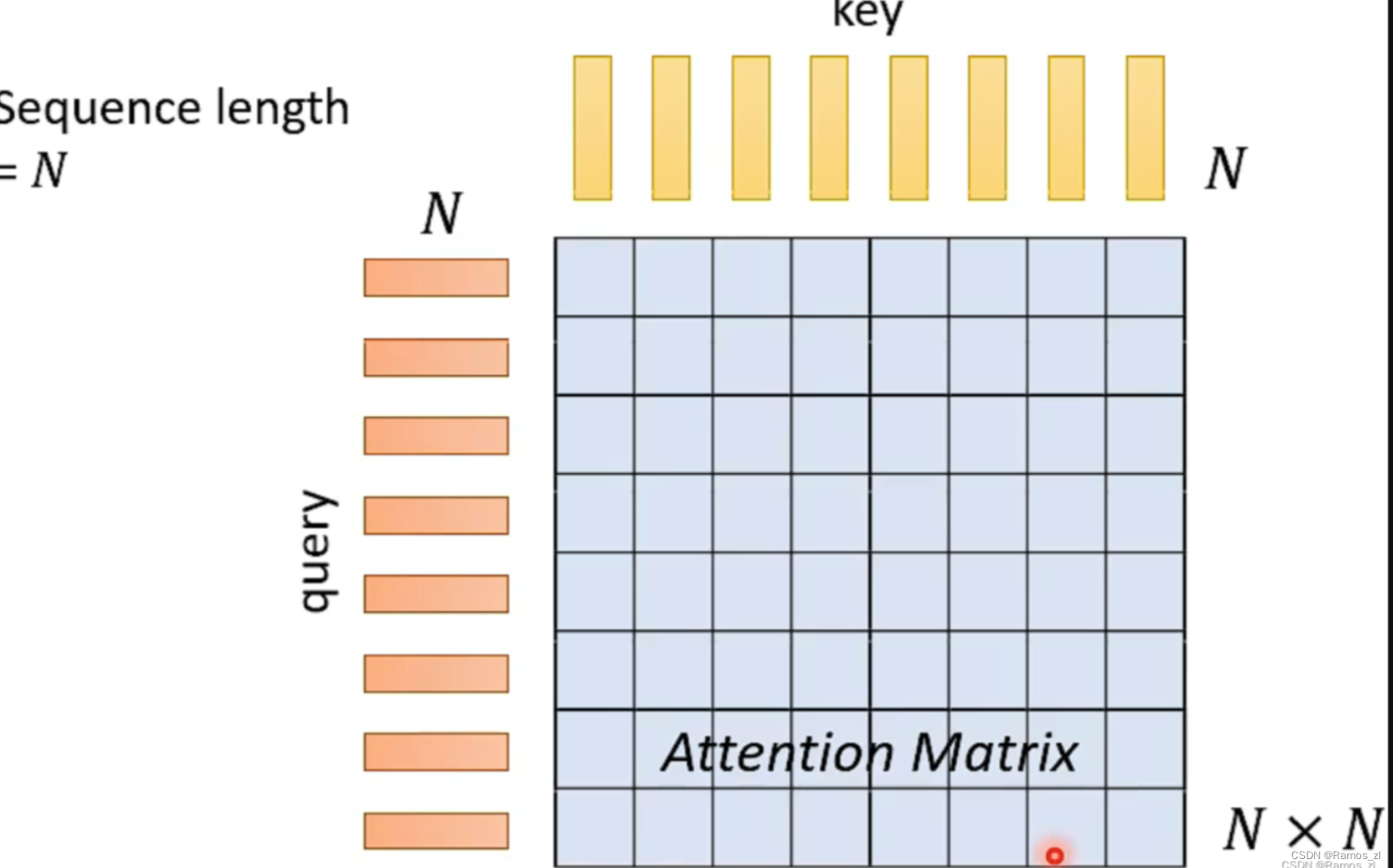

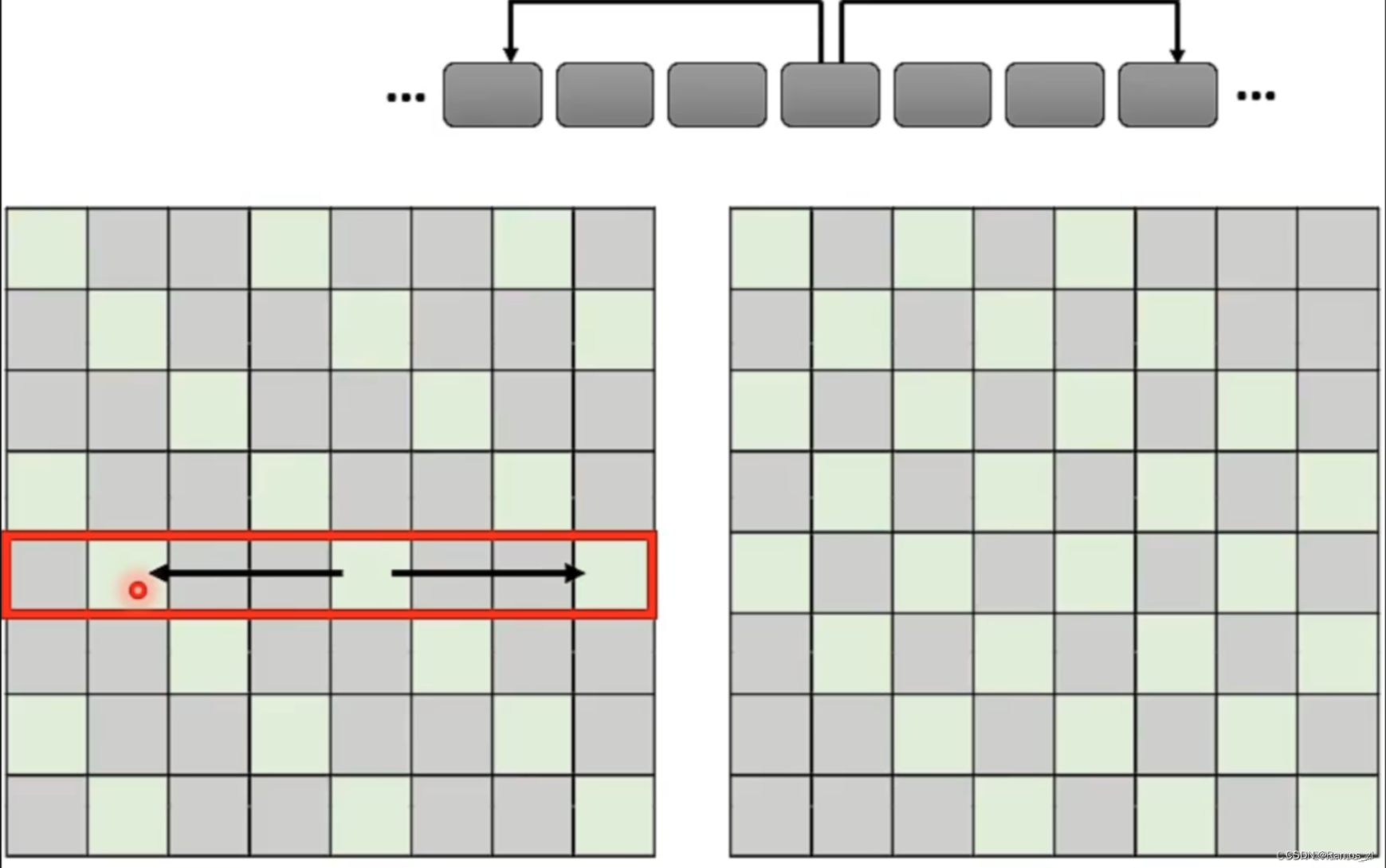

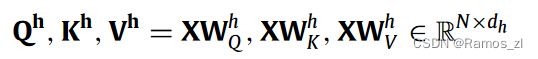

作为注意力机制的一种变体,SAN通过计算每对输入token之间的相关性来产生输入序列的单词级表示。在相同的表示上应用多个单独的注意力函数可以进一步提高基于注意力机制的性能,即多头机制,如图所示。多中心语机制的每个中心语都可以作为对输入句的特定看法。在这里,我们首先介绍了该机制的流程。在形式上,该模型首先将输入序列X = { x1,…,xN }∈RN × d映射到具有不同线性投影的H个子空间(视图)中:

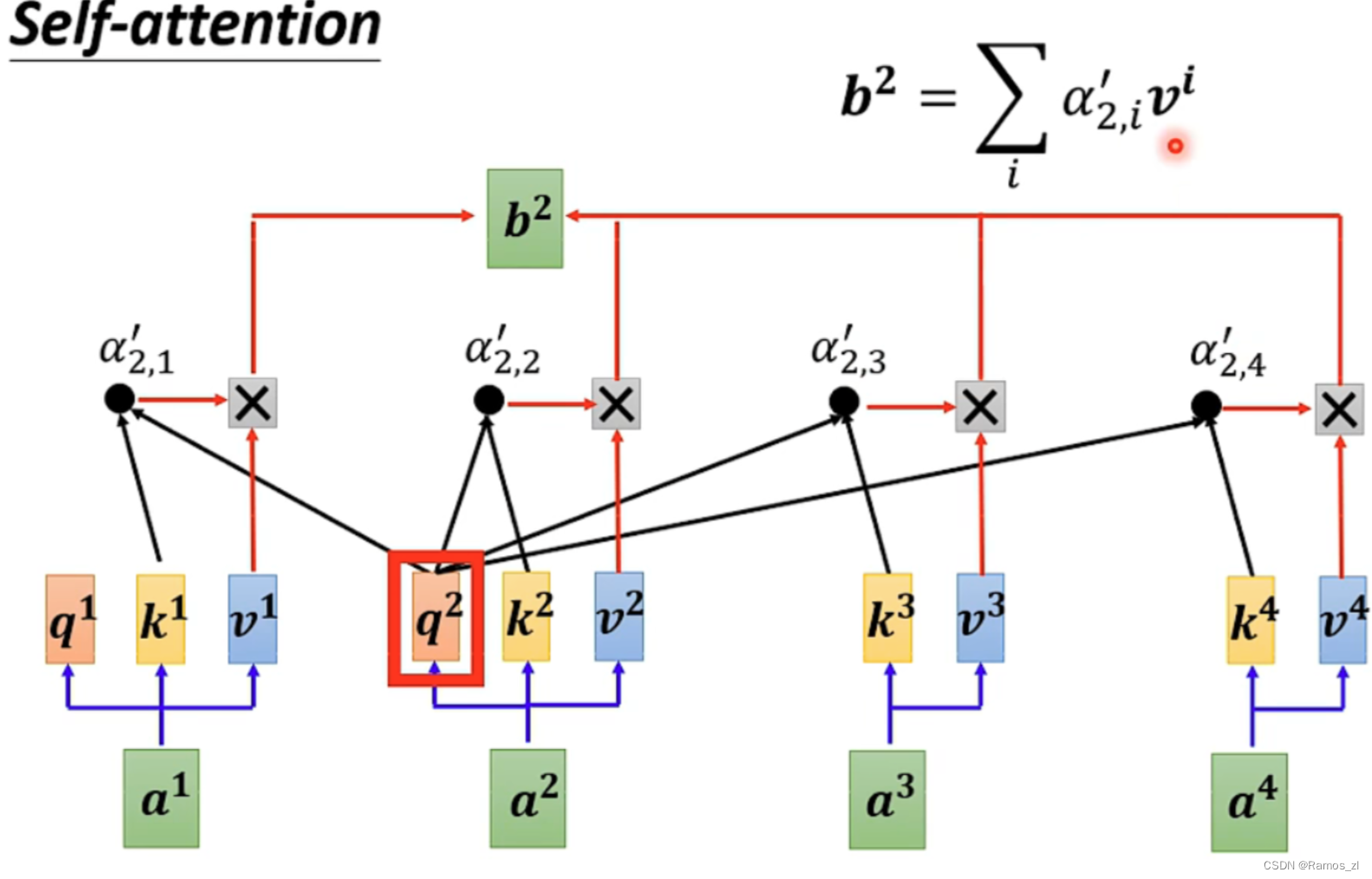

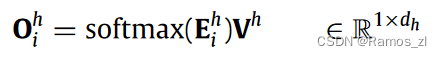

序列Oh = { Oh1,…,OhN }的第i个输出Ohi是值Vh的加权和:

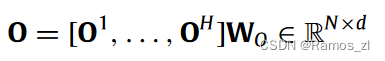

Ehi∈R1 × N表示当前查询Qhi和关键字Kh之间的注意力能量,它是通过一个缩放的点积注意力来计算的。为了整合从多头注意力机制的每个头收集的信息,将输出状态进行级联,然后进行线性变换:

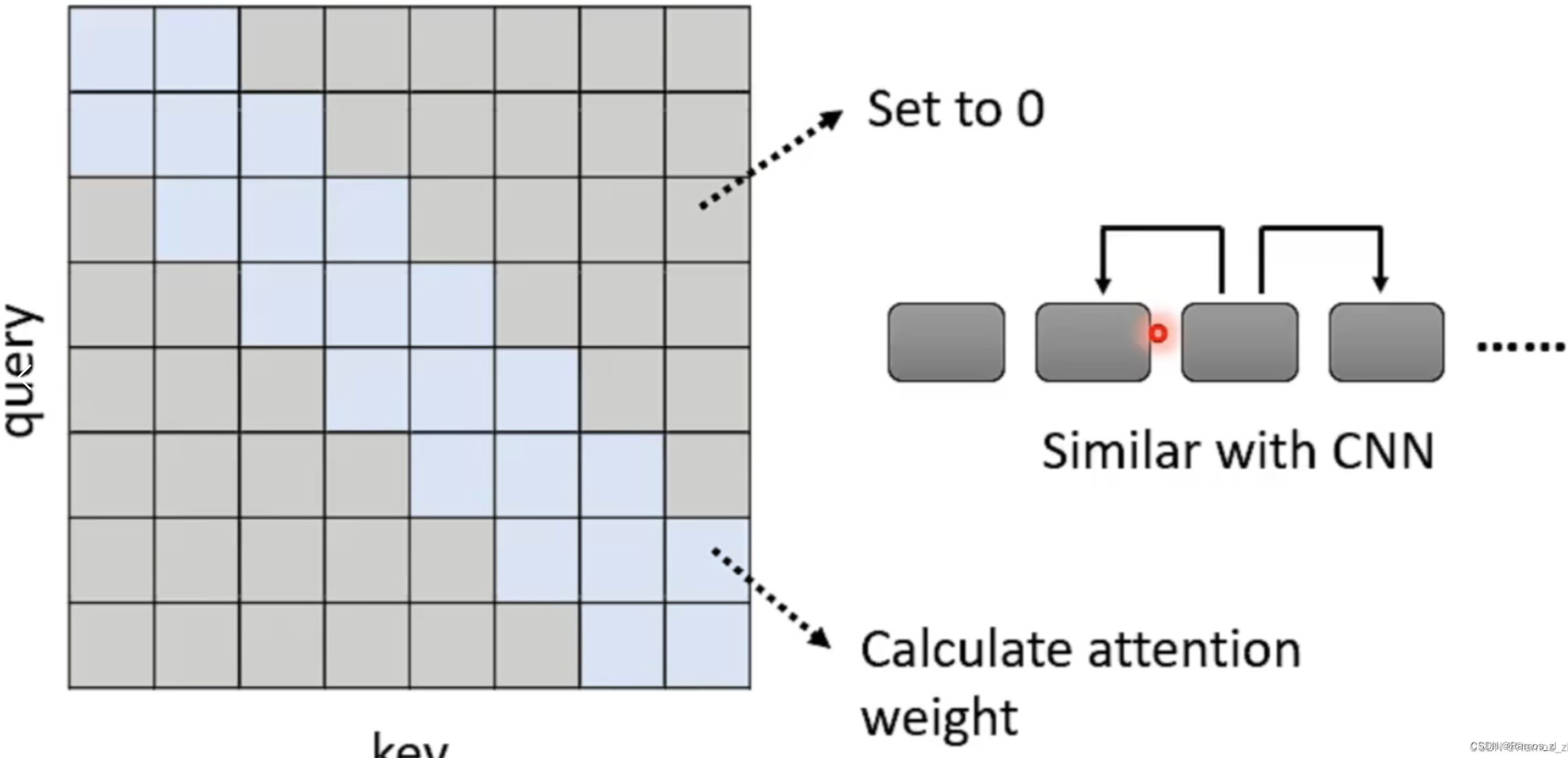

多头机制较好地兼顾了整个序列,没有任何的指导方针。因此,不同的头脑可能会学习相同的语言属性,并抑制一些重要关系的提取。为了解决这些问题,一种替代的方法是给多个中心点分配特定的任务,例如,引导每个中心点专注于输入句子的某一方面。