本文介绍: 目前已经讲解了目前LLM的三大流派的两个起始模型:GPT-1(Decoder only)、BERT(Encoder only),但是这两个模型针对不同下游不同的NLP任务时还需要进行一定的修改(如添加一些线性层),Google经过庞大的预训练,最终提出了一个通用框架T5模型(Encoder-Decoder), 将所有NLP任务转化为text to text任务,微调时无需再修改模型,直接在原模型上微调即可。ps:T5最核心的理念是:使用前缀任务声明及文本答案生成,统一所有自然语言处理任务的输入和输出。

前言

目前已经讲解了目前LLM的三大流派的两个起始模型:GPT-1(Decoder only)、BERT(Encoder only),但是这两个模型针对不同下游不同的NLP任务时还需要进行一定的修改(如添加一些线性层),Google经过庞大的预训练,最终提出了一个通用框架T5模型(Encoder-Decoder), 将所有NLP任务转化为text to text任务,微调时无需再修改模型,直接在原模型上微调即可。

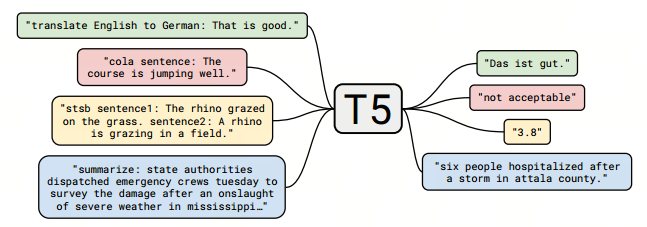

下图所示为T5的输入格式和输出格式。绿色部分表示翻译任务,红色和黄色部分分别表示CoLA(单句分类)和STS-B(文本语义相似度)任务,蓝色部分表示摘要生成任务,左侧的框表示T5的输入样例,右侧的框则是对应的输出结果。

T5唯一需要做的就是在输入数据前加上任务声明前缀,如:

提示:以下是本篇文章正文内容,下面内容可供参考

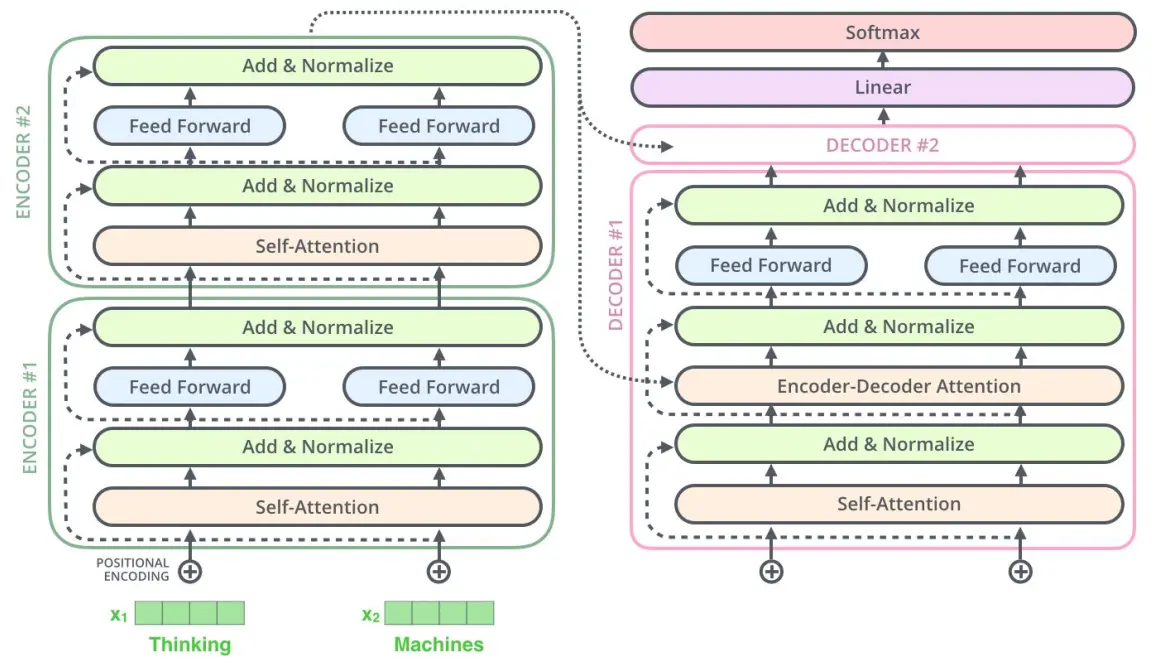

一、T5的网络结构和流程

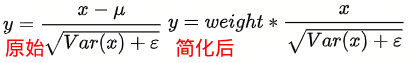

T5模型和原始的Transformer结构基本一致,具体的做了如下几点改动:

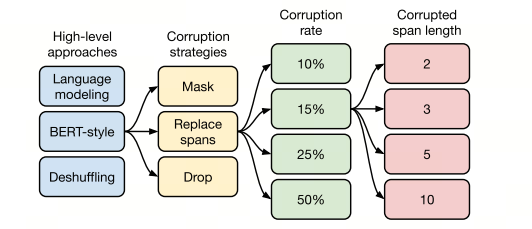

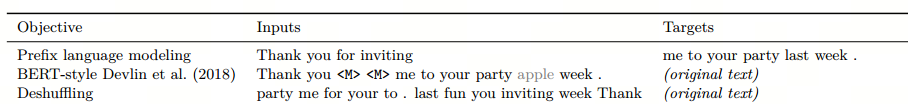

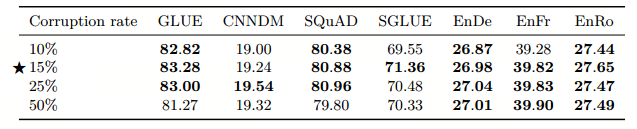

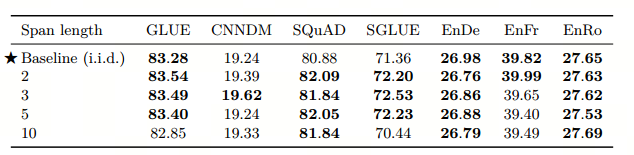

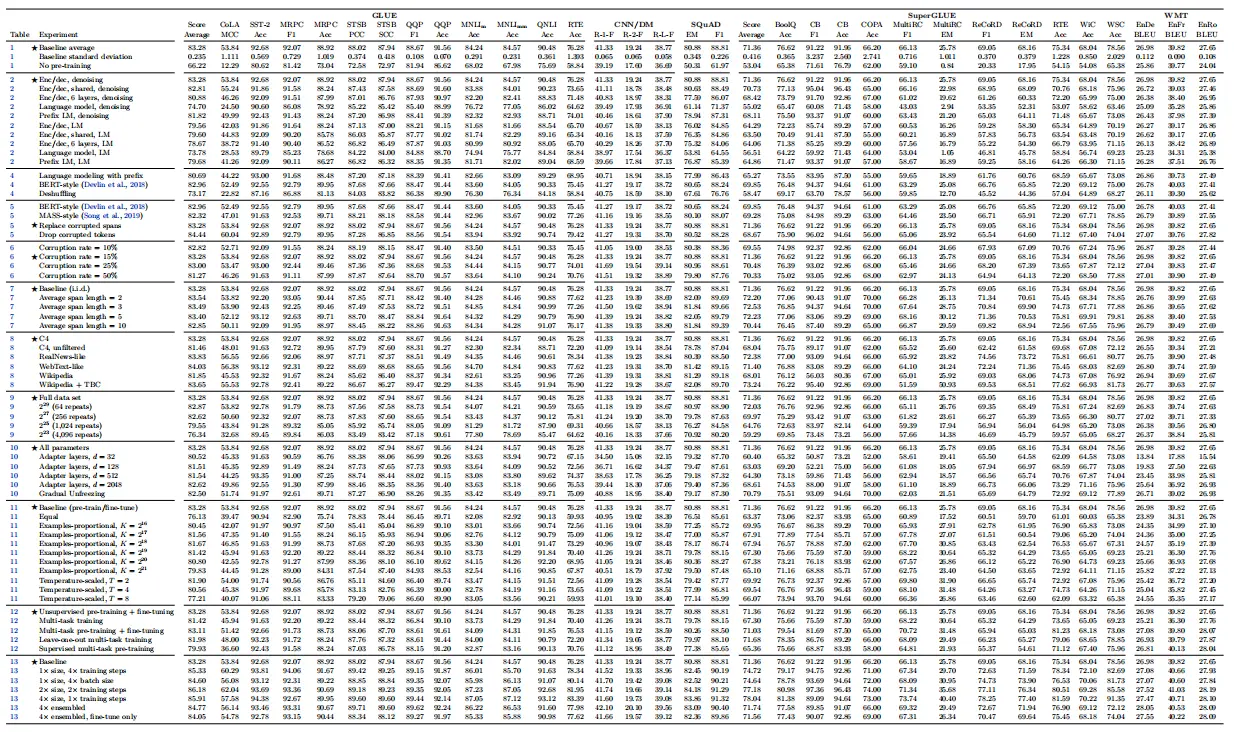

二、T5的预训练过程

三、其他训练结论

总结

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。