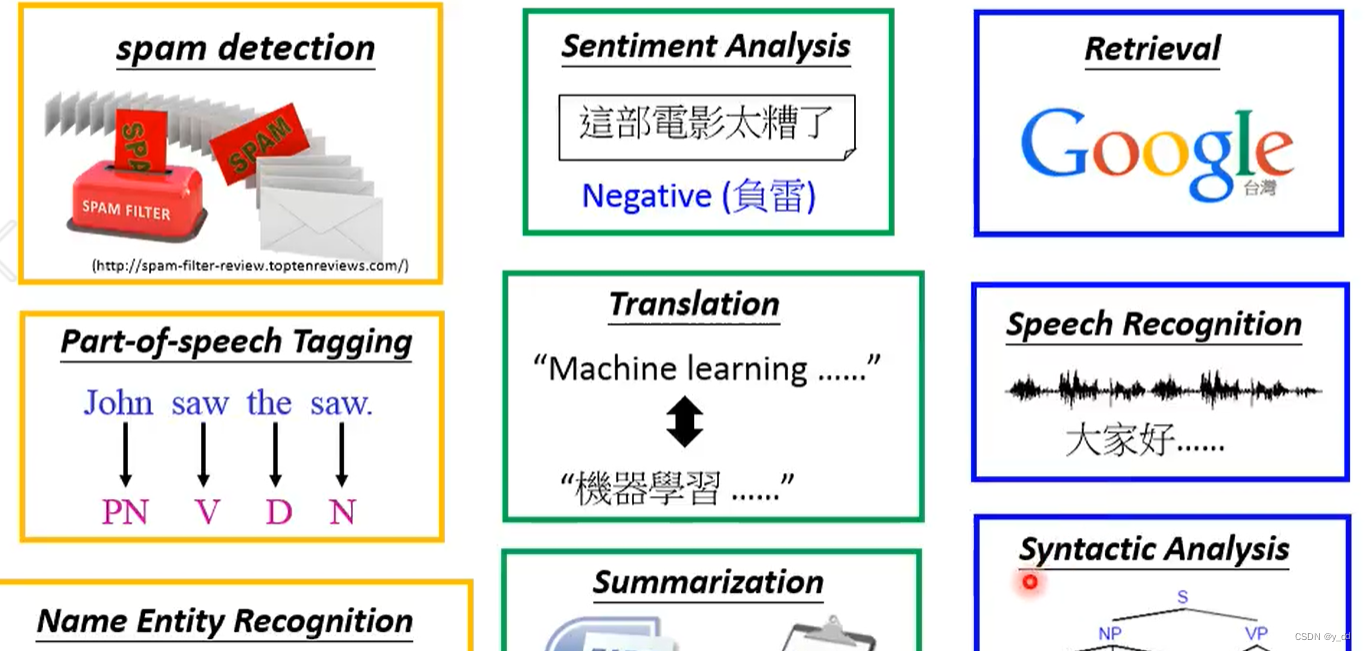

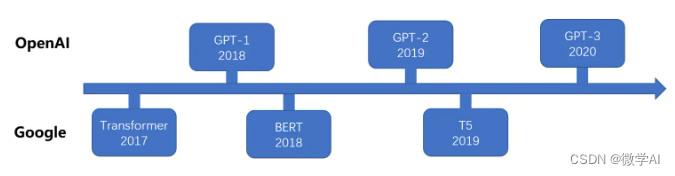

大家好,我是微学AI,今天给大家介绍一下自然语言处理24-T5模型的介绍与训练过程,利用简单构造数据训练微调该模型,体验整个过程。在大模型ChatGPT发布之前,NLP领域是BERT,T5模型为主导,T5(Text-to-Text Transfer Transformer)是一种由Google Brain团队在2019年提出的自然语言处理模型。T5模型基于Transformer结构,可以执行多种自然语言任务,如翻译、摘要、问答、文本生成等。它不同于其他模型的地方在于,T5模型采用了统一的输入输出格式,并通过微调来适应不同的任务。

基于transformer大模型的发展过程

一、T5模型的介绍

T5模型基于Transformer结构,包含有编码器与解码器。编码器将输入语句转换成一组向量表示,而解码器则将向量表示转换成对应的输出。在T5模型中,编码器和解码器采用相同的transformer结构,并共享参数,这相当于在一个模型中同时学习多个任务。要训练T5模型,我们首先将大量的文本数据输入到模型中进行预训练,使得模型学习到了输入和输出之间的对应关系。而后,再利用有标注的数据对模型进行微调,以适应具体的任务需求。与其他自然语言处理模型相比,T5具备以下优势:

多任务学习能力强:同一个模型可以执行多种自然语言任务,只需要使用不同的微调方法即可。

零样本学习能力强:T5模型可以利用已有知识完成类似但未曾见过的任务。

原文地址:https://blog.csdn.net/weixin_42878111/article/details/135336586

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若转载,请注明出处:http://www.7code.cn/show_53536.html

如若内容造成侵权/违法违规/事实不符,请联系代码007邮箱:suwngjj01@126.com进行投诉反馈,一经查实,立即删除!